Erstellen Sie starke empirische Evaluierungen

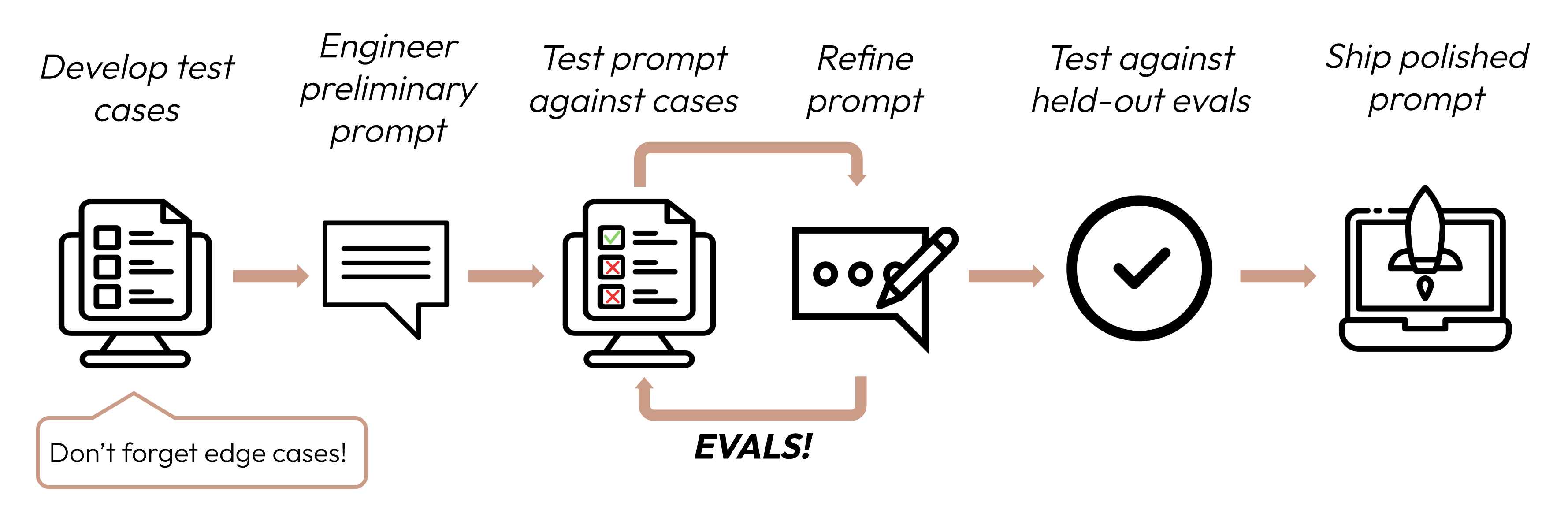

Nach der Definition Ihrer Erfolgskriterien besteht der nächste Schritt darin, Evaluierungen zu entwerfen, um die LLM-Leistung gegen diese Kriterien zu messen. Dies ist ein wichtiger Teil des Prompt-Engineering-Zyklus.

Dieser Leitfaden konzentriert sich auf die Entwicklung Ihrer Testfälle.

Evals und Testfälle erstellen

Eval-Designprinzipien

- Aufgabenspezifisch sein: Entwerfen Sie Evals, die Ihre reale Aufgabenverteilung widerspiegeln. Vergessen Sie nicht, Grenzfälle einzubeziehen!

- Automatisieren Sie, wenn möglich: Strukturieren Sie Fragen so, dass automatisierte Bewertung möglich ist (z. B. Multiple-Choice, String-Abgleich, Code-bewertet, LLM-bewertet).

- Priorisieren Sie Volumen über Qualität: Mehr Fragen mit leicht niedrigerem Signal automatisierter Bewertung ist besser als weniger Fragen mit hochqualitativen manuell bewerteten Evals.

Beispiel-Evals

Evals bewerten

Bei der Entscheidung, welche Methode zum Bewerten von Evals verwendet werden soll, wählen Sie die schnellste, zuverlässigste und skalierbarste Methode:

-

Code-basierte Bewertung: Am schnellsten und zuverlässigsten, äußerst skalierbar, aber auch mangelnde Nuance für komplexere Urteile, die weniger regelbasierte Starrheit erfordern.

- Exact Match:

output == golden_answer - String Match:

key_phrase in output

- Exact Match:

-

Menschliche Bewertung: Am flexibelsten und höchster Qualität, aber langsam und teuer. Vermeiden Sie wenn möglich.

-

LLM-basierte Bewertung: Schnell und flexibel, skalierbar und geeignet für komplexe Urteile. Testen Sie zuerst auf Zuverlässigkeit, dann skalieren Sie.

Tipps für LLM-basierte Bewertung

- Haben Sie detaillierte, klare Rubriken: „Die Antwort sollte immer ‚Acme Inc.' im ersten Satz erwähnen. Wenn nicht, wird die Antwort automatisch als ‚falsch' bewertet."

Ein bestimmter Anwendungsfall oder sogar ein spezifisches Erfolgskriterium für diesen Anwendungsfall könnte mehrere Rubriken für eine ganzheitliche Bewertung erfordern.

- Empirisch oder spezifisch: Weisen Sie das LLM beispielsweise an, nur „korrekt" oder „falsch" auszugeben, oder urteilen Sie auf einer Skala von 1-5. Rein qualitative Bewertungen sind schwer schnell und im großen Maßstab zu bewerten.

- Fördern Sie Überlegungen: Bitten Sie das LLM, zuerst zu überlegen, bevor es eine Bewertungspunktzahl entscheidet, und verwerfen Sie dann die Überlegungen. Dies verbessert die Bewertungsleistung, besonders für Aufgaben, die komplexe Urteile erfordern.

Nächste Schritte

Erfahren Sie, wie Sie Prompts erstellen, die Ihre Eval-Scores maximieren.

Weitere Codebeispiele von manuell-, Code- und LLM-bewerteten Evals.

Was this page helpful?