Verwendung des Evaluierungs-Tools

Zugriff auf die Evaluierungs-Funktion

Um mit dem Evaluierungs-Tool zu beginnen:

- Öffnen Sie die Claude Console und navigieren Sie zum Prompt-Editor.

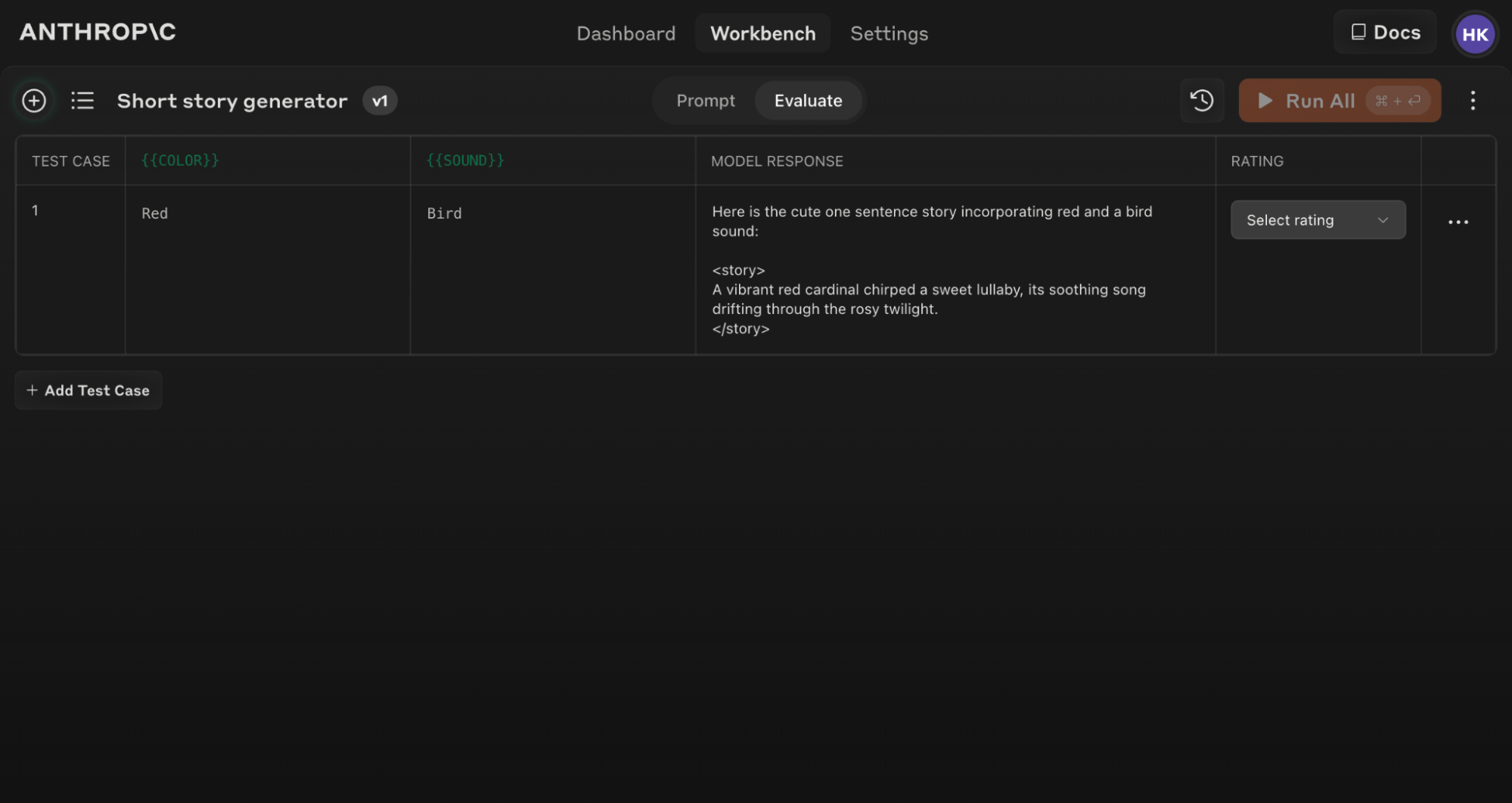

- Nachdem Sie Ihren Prompt verfasst haben, suchen Sie nach dem 'Evaluieren'-Tab oben auf dem Bildschirm.

Stellen Sie sicher, dass Ihr Prompt mindestens 1-2 dynamische Variablen mit der doppelten geschweiften Klammer-Syntax enthält: {{variable}}. Dies ist erforderlich für die Erstellung von Evaluierungs-Testsets.

Generierung von Prompts

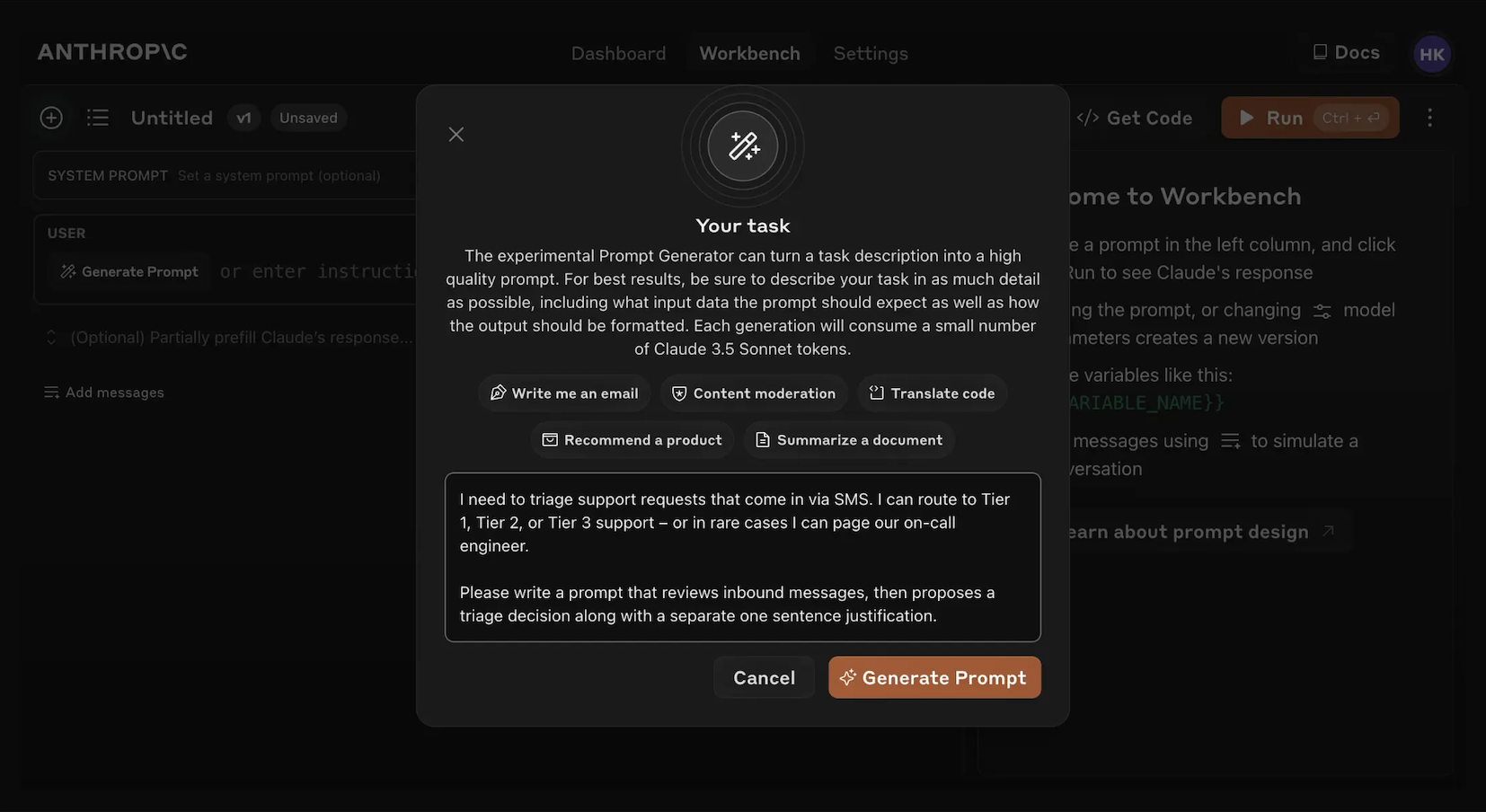

Die Console bietet einen eingebauten Prompt-Generator, der von Claude Opus 4.1 betrieben wird:

Klicken Sie auf 'Prompt Generieren'

Das Klicken auf das 'Prompt Generieren'-Hilfstool öffnet ein Modal, in dem Sie Ihre Aufgabeninformationen eingeben können.

Beschreiben Sie Ihre Aufgabe

Beschreiben Sie Ihre gewünschte Aufgabe (z.B. "Eingehende Kundensupport-Anfragen triagieren") mit so viel oder so wenig Detail, wie Sie möchten. Je mehr Kontext Sie einbeziehen, desto mehr kann Claude seinen generierten Prompt an Ihre spezifischen Bedürfnisse anpassen.

Generieren Sie Ihren Prompt

Das Klicken auf den orangenen 'Prompt Generieren'-Button unten lässt Claude einen hochwertigen Prompt für Sie generieren. Sie können diese Prompts dann mit dem Evaluierungs-Bildschirm in der Console weiter verbessern.

Diese Funktion macht es einfacher, Prompts mit der entsprechenden Variablen-Syntax für die Evaluierung zu erstellen.

Erstellung von Testfällen

Wenn Sie auf den Evaluierungs-Bildschirm zugreifen, haben Sie mehrere Optionen zur Erstellung von Testfällen:

- Klicken Sie auf den '+ Zeile hinzufügen'-Button unten links, um manuell einen Fall hinzuzufügen.

- Verwenden Sie die 'Testfall Generieren'-Funktion, um Claude automatisch Testfälle für Sie generieren zu lassen.

- Importieren Sie Testfälle aus einer CSV-Datei.

Um die 'Testfall Generieren'-Funktion zu verwenden:

Klicken Sie auf 'Testfall Generieren'

Claude wird Testfälle für Sie generieren, eine Zeile nach der anderen für jedes Mal, wenn Sie den Button klicken.

Generierungslogik bearbeiten (optional)

Sie können auch die Testfall-Generierungslogik bearbeiten, indem Sie auf den Pfeil-Dropdown rechts neben dem 'Testfall Generieren'-Button klicken, dann auf 'Generierungslogik anzeigen' oben im Variablen-Fenster, das sich öffnet. Möglicherweise müssen Sie auf 'Generieren' oben rechts in diesem Fenster klicken, um die anfängliche Generierungslogik zu füllen.

Das Bearbeiten ermöglicht es Ihnen, die Testfälle, die Claude generiert, mit größerer Präzision und Spezifität anzupassen und fein abzustimmen.

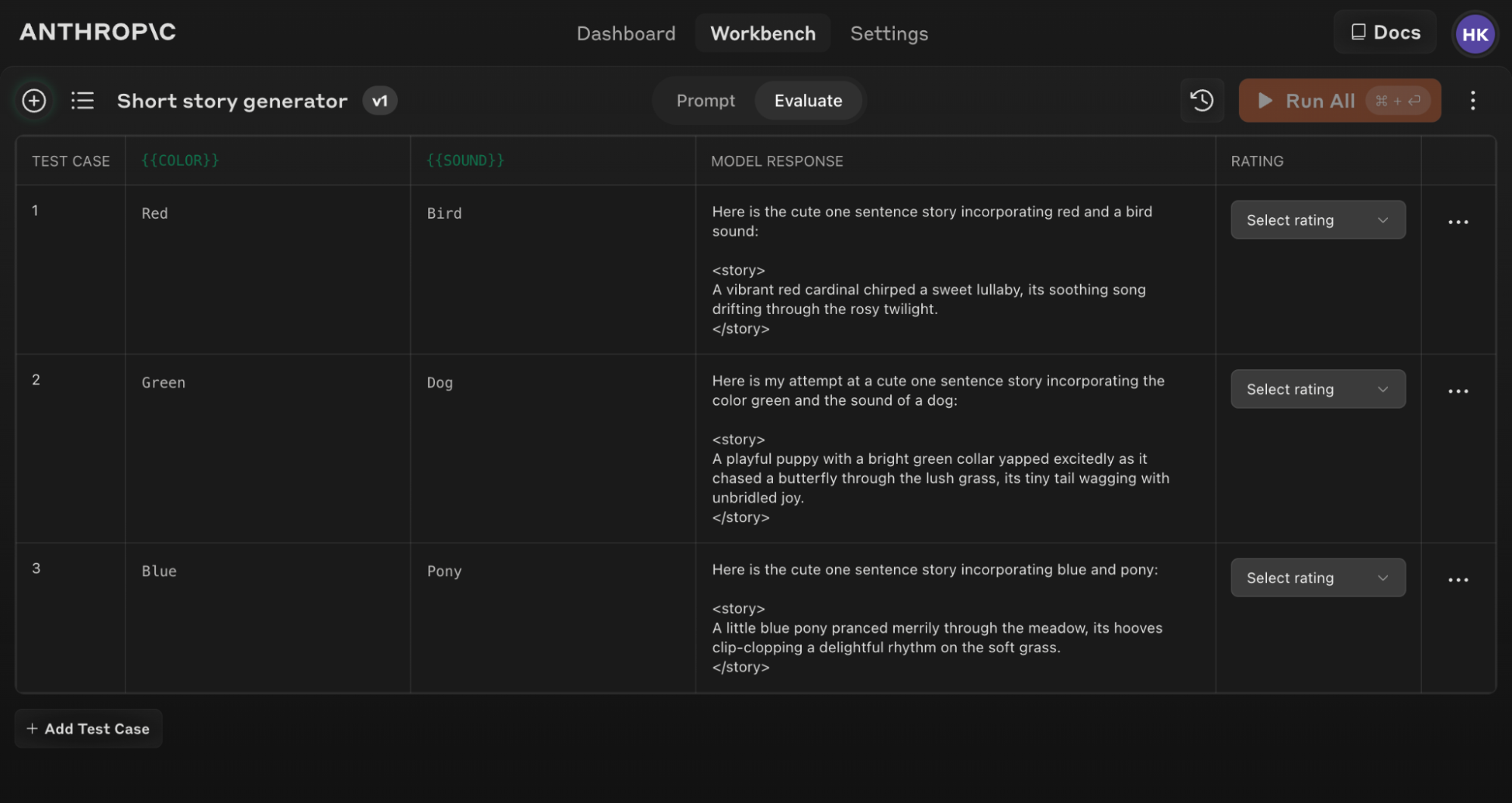

Hier ist ein Beispiel eines gefüllten Evaluierungs-Bildschirms mit mehreren Testfällen:

Wenn Sie Ihren ursprünglichen Prompt-Text aktualisieren, können Sie die gesamte Evaluierungs-Suite gegen den neuen Prompt erneut ausführen, um zu sehen, wie sich Änderungen auf die Leistung über alle Testfälle hinweg auswirken.

Tipps für effektive Evaluierung

Verwenden Sie das 'Prompt generieren'-Hilfstool in der Console, um schnell Prompts mit der entsprechenden Variablen-Syntax für die Evaluierung zu erstellen.

Verstehen und Vergleichen von Ergebnissen

Das Evaluierungs-Tool bietet mehrere Funktionen, um Ihnen bei der Verfeinerung Ihrer Prompts zu helfen:

- Seite-an-Seite-Vergleich: Vergleichen Sie die Ausgaben von zwei oder mehr Prompts, um schnell die Auswirkungen Ihrer Änderungen zu sehen.

- Qualitätsbewertung: Bewerten Sie die Antwortqualität auf einer 5-Punkte-Skala, um Verbesserungen in der Antwortqualität pro Prompt zu verfolgen.

- Prompt-Versionierung: Erstellen Sie neue Versionen Ihres Prompts und führen Sie die Test-Suite erneut aus, um schnell zu iterieren und Ergebnisse zu verbessern.

Durch die Überprüfung der Ergebnisse über Testfälle hinweg und den Vergleich verschiedener Prompt-Versionen können Sie Muster erkennen und informierte Anpassungen an Ihrem Prompt effizienter vornehmen.

Beginnen Sie heute mit der Evaluierung Ihrer Prompts, um robustere KI-Anwendungen mit Claude zu erstellen!

Was this page helpful?