Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

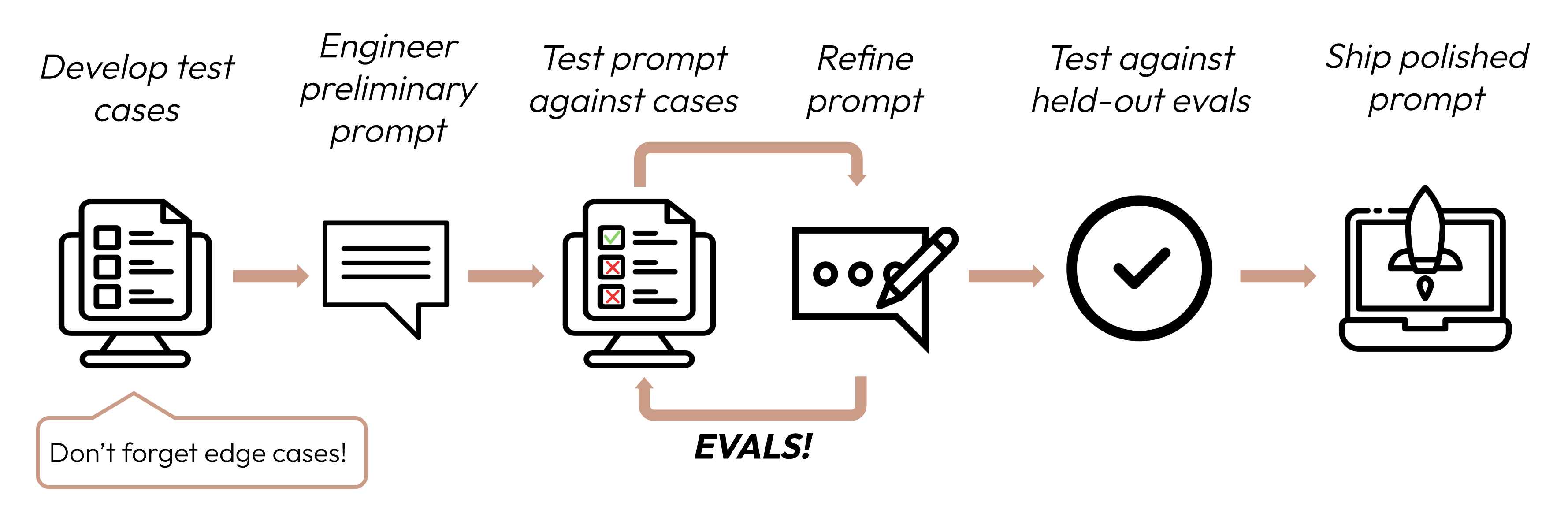

成功基準を定義した後、次のステップはそれらの基準に対してLLMのパフォーマンスを測定するための評価を設計することです。これはプロンプトエンジニアリングサイクルの重要な部分です。

このガイドでは、テストケースの開発方法に焦点を当てます。

評価を採点する方法を決定する際は、最も速く、最も信頼性が高く、最もスケーラブルな方法を選択してください:

コードベースの採点:最も速く、最も信頼性が高く、非常にスケーラブルですが、ルールベースの厳密さでは対応できない、より複雑な判断にはニュアンスが欠けます。

output == golden_answerkey_phrase in output人間による採点:最も柔軟で高品質ですが、遅くてコストがかかります。可能な限り避けてください。

LLMベースの採点:高速で柔軟、スケーラブルで複雑な判断に適しています。まず信頼性をテストしてからスケールしてください。

Was this page helpful?