Utilizzo dello Strumento di Valutazione

Accesso alla Funzione di Valutazione

Per iniziare con lo strumento di Valutazione:

- Apri la Claude Console e naviga verso l'editor di prompt.

- Dopo aver composto il tuo prompt, cerca la scheda 'Evaluate' nella parte superiore dello schermo.

Assicurati che il tuo prompt includa almeno 1-2 variabili dinamiche utilizzando la sintassi delle doppie parentesi graffe: {{variable}}. Questo è necessario per creare set di test di valutazione.

Generazione di Prompt

La Console offre un generatore di prompt integrato alimentato da Claude Opus 4.1:

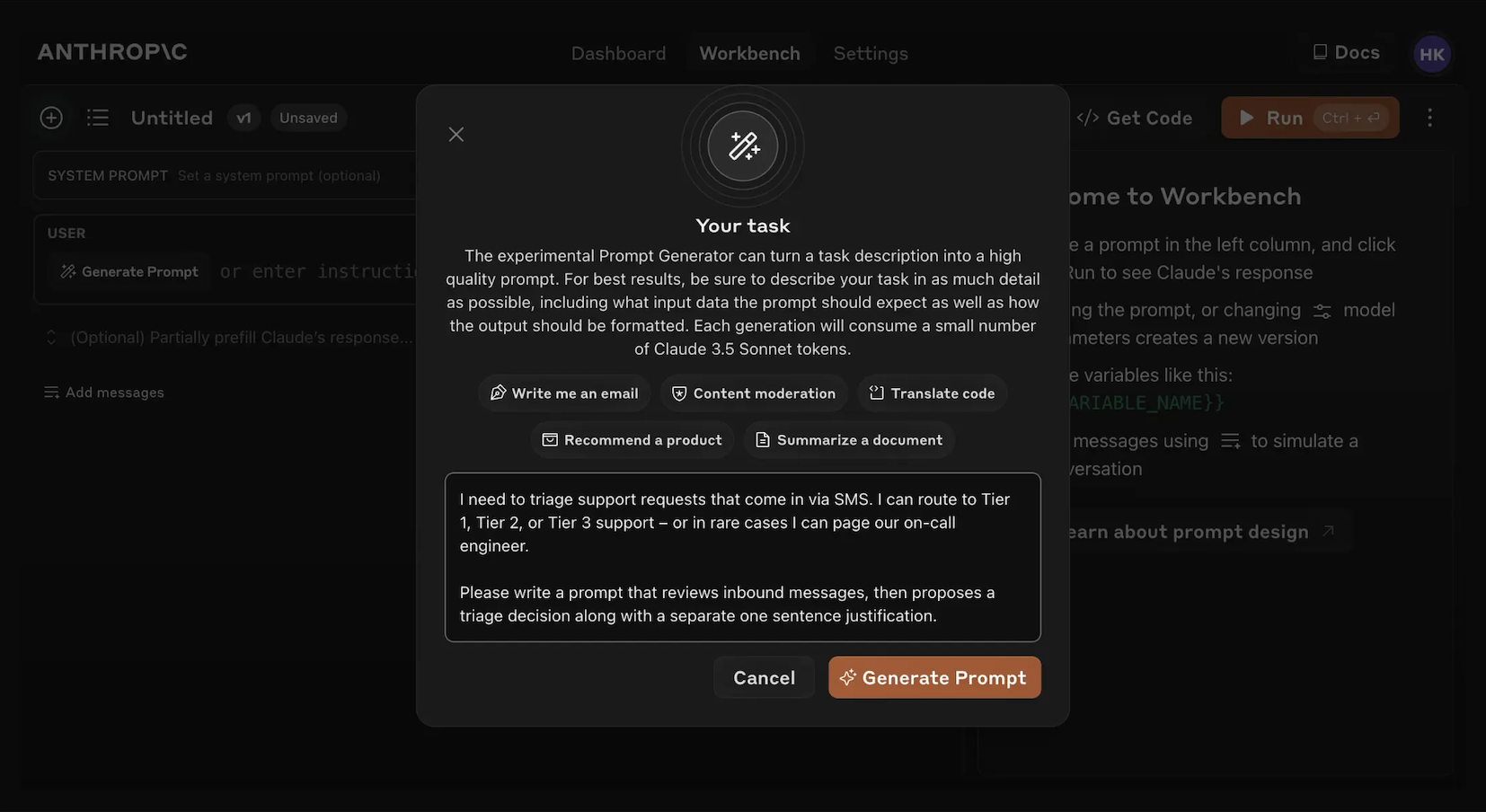

Clicca 'Generate Prompt'

Cliccando sullo strumento helper 'Generate Prompt' si aprirà una finestra modale che ti permette di inserire le informazioni del tuo compito.

Descrivi il tuo compito

Descrivi il compito desiderato (ad esempio, "Smistare le richieste di supporto clienti in entrata") con tutti i dettagli che desideri o con pochi dettagli. Più contesto includi, più Claude può adattare il prompt generato alle tue esigenze specifiche.

Genera il tuo prompt

Cliccando il pulsante arancione 'Generate Prompt' in basso, Claude genererà un prompt di alta qualità per te. Puoi poi migliorare ulteriormente quei prompt utilizzando la schermata di Valutazione nella Console.

Questa funzione rende più facile creare prompt con la sintassi delle variabili appropriata per la valutazione.

Creazione di Casi di Test

Quando accedi alla schermata di Valutazione, hai diverse opzioni per creare casi di test:

- Clicca il pulsante '+ Add Row' in basso a sinistra per aggiungere manualmente un caso.

- Usa la funzione 'Generate Test Case' per far generare automaticamente casi di test a Claude.

- Importa casi di test da un file CSV.

Per utilizzare la funzione 'Generate Test Case':

Clicca su 'Generate Test Case'

Claude genererà casi di test per te, una riga alla volta per ogni volta che clicchi il pulsante.

Modifica la logica di generazione (opzionale)

Puoi anche modificare la logica di generazione dei casi di test cliccando sul menu a discesa con la freccia a destra del pulsante 'Generate Test Case', poi su 'Show generation logic' nella parte superiore della finestra Variables che appare. Potresti dover cliccare `Generate' in alto a destra di questa finestra per popolare la logica di generazione iniziale.

Modificare questo ti permette di personalizzare e affinare i casi di test che Claude genera con maggiore precisione e specificità.

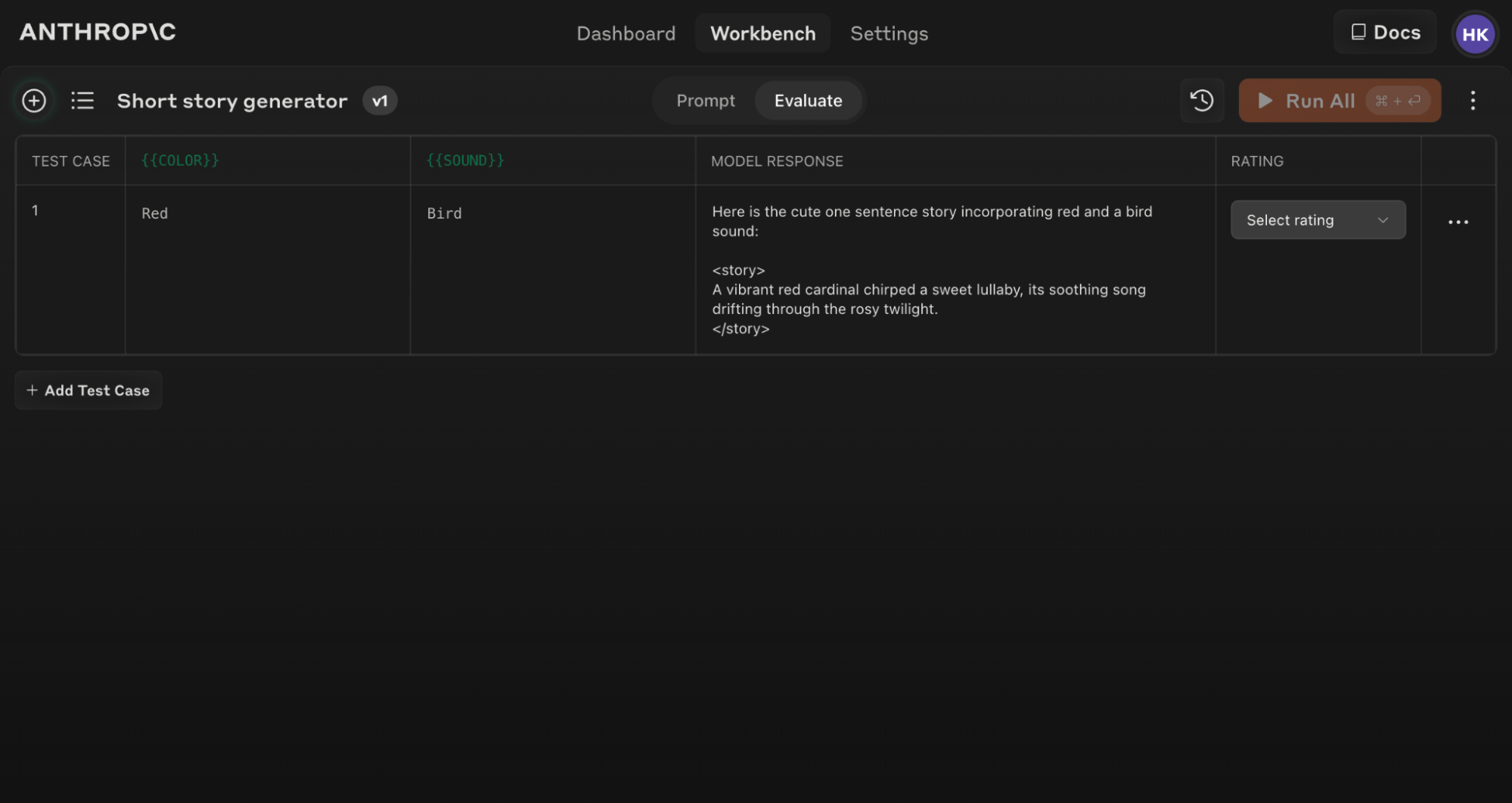

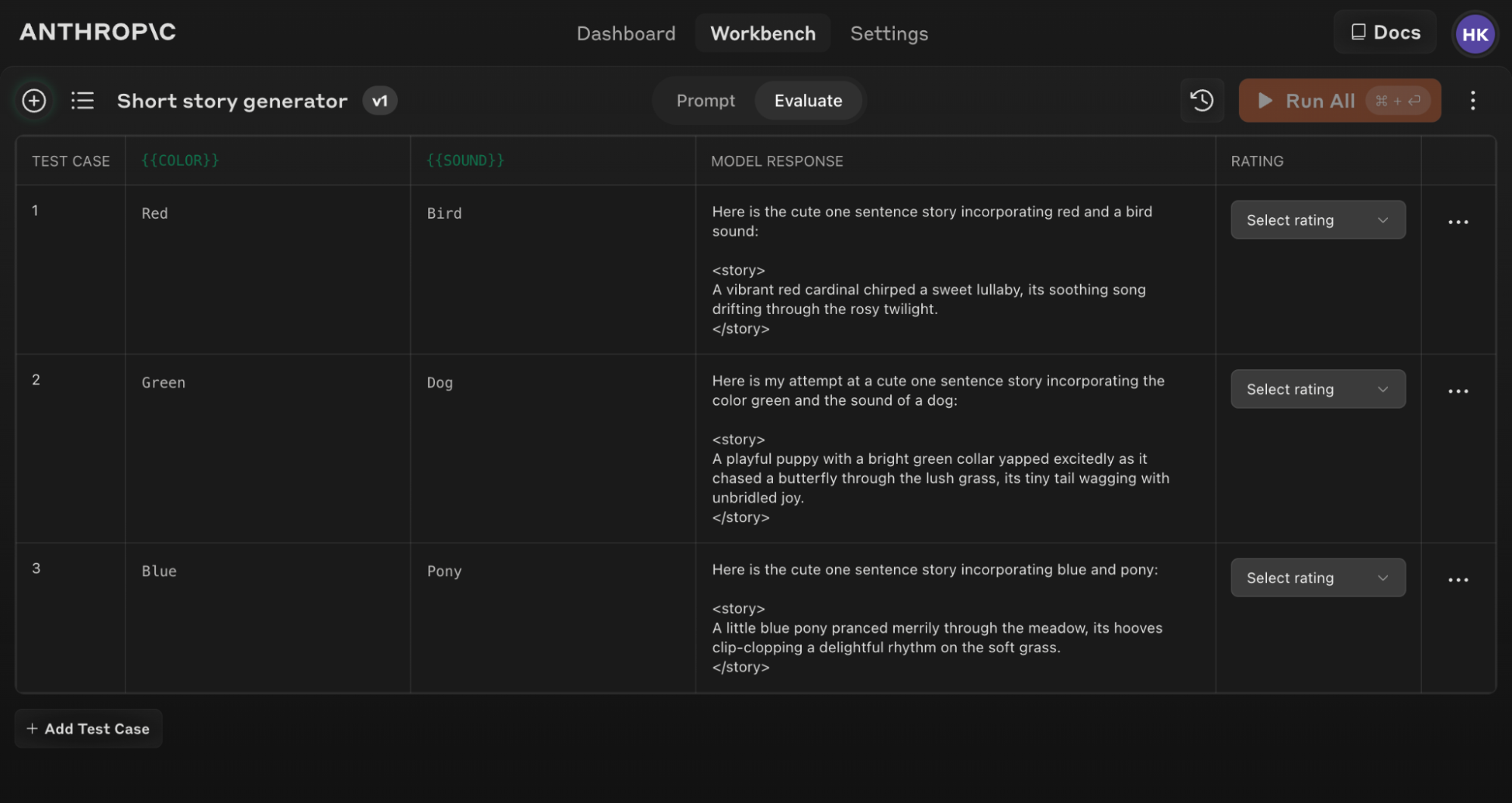

Ecco un esempio di una schermata di Valutazione popolata con diversi casi di test:

Se aggiorni il testo del tuo prompt originale, puoi rieseguire l'intera suite di valutazione contro il nuovo prompt per vedere come i cambiamenti influenzano le prestazioni su tutti i casi di test.

Consigli per una Valutazione Efficace

Usa lo strumento helper 'Generate a prompt' nella Console per creare rapidamente prompt con la sintassi delle variabili appropriata per la valutazione.

Comprensione e confronto dei risultati

Lo strumento di Valutazione offre diverse funzioni per aiutarti a raffinare i tuoi prompt:

- Confronto affiancato: Confronta gli output di due o più prompt per vedere rapidamente l'impatto dei tuoi cambiamenti.

- Valutazione della qualità: Valuta la qualità delle risposte su una scala di 5 punti per tracciare i miglioramenti nella qualità delle risposte per prompt.

- Versionamento dei prompt: Crea nuove versioni del tuo prompt e riesegui la suite di test per iterare rapidamente e migliorare i risultati.

Rivedendo i risultati attraverso i casi di test e confrontando diverse versioni di prompt, puoi individuare pattern e fare aggiustamenti informati al tuo prompt in modo più efficiente.

Inizia a valutare i tuoi prompt oggi per costruire applicazioni AI più robuste con Claude!

Was this page helpful?