Creare valutazioni empiriche forti

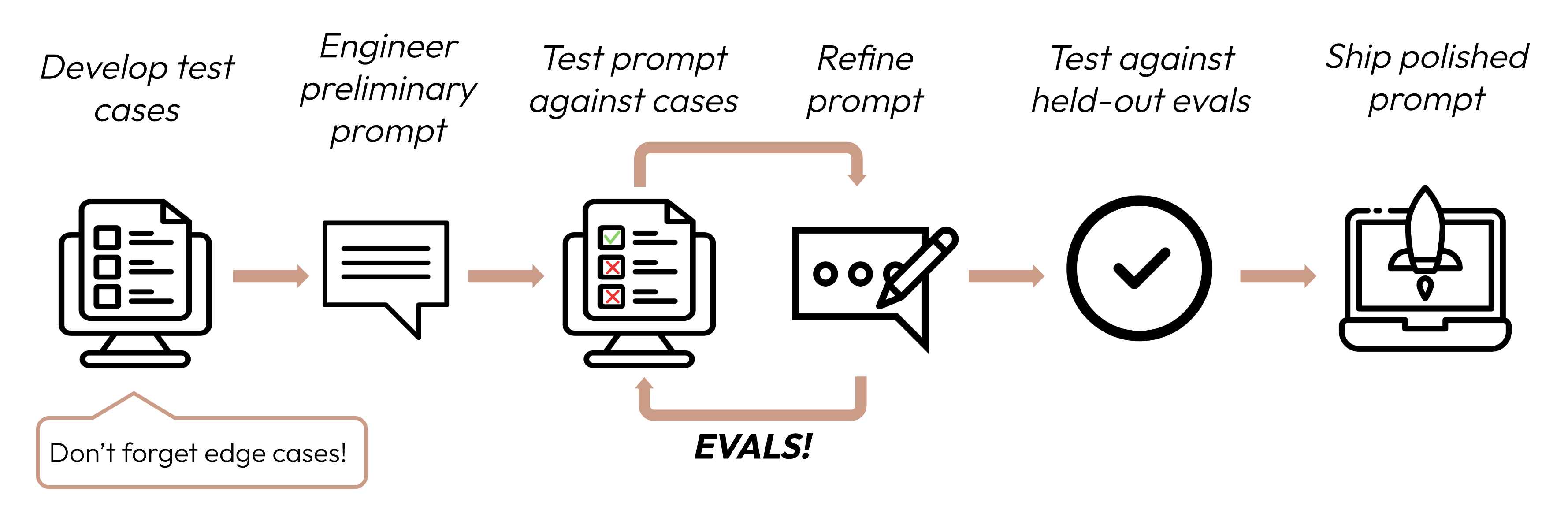

Dopo aver definito i tuoi criteri di successo, il passo successivo è progettare valutazioni per misurare le prestazioni dell'LLM rispetto a tali criteri. Questa è una parte vitale del ciclo di prompt engineering.

Questa guida si concentra su come sviluppare i tuoi test case.

Costruire evals e test case

Principi di progettazione delle eval

- Essere specifici per il compito: Progetta eval che rispecchiano la distribuzione dei compiti nel mondo reale. Non dimenticare di considerare i casi limite!

- Automatizzare quando possibile: Struttura le domande per consentire la valutazione automatizzata (ad es., scelta multipla, corrispondenza di stringhe, valutazione basata su codice, valutazione basata su LLM).

- Dare priorità al volume rispetto alla qualità: Più domande con valutazione automatizzata leggermente meno precisa è meglio di meno domande con eval di alta qualità valutate manualmente da umani.

Esempio di eval

Valutazione delle eval

Quando decidi quale metodo utilizzare per valutare le eval, scegli il metodo più veloce, affidabile e scalabile:

-

Valutazione basata su codice: La più veloce e affidabile, estremamente scalabile, ma manca di sfumature per giudizi più complessi che richiedono una rigidità meno basata su regole.

- Corrispondenza esatta:

output == golden_answer - Corrispondenza di stringhe:

key_phrase in output

- Corrispondenza esatta:

-

Valutazione umana: La più flessibile e di alta qualità, ma lenta e costosa. Evita se possibile.

-

Valutazione basata su LLM: Veloce e flessibile, scalabile e adatta a giudizi complessi. Testa prima per garantire l'affidabilità, quindi scala.

Suggerimenti per la valutazione basata su LLM

- Avere rubriche dettagliate e chiare: "La risposta dovrebbe sempre menzionare 'Acme Inc.' nella prima frase. Se non lo fa, la risposta viene automaticamente valutata come 'scorretta'."

Un determinato caso di utilizzo, o anche un criterio di successo specifico per quel caso di utilizzo, potrebbe richiedere diverse rubriche per una valutazione olistica.

- Empirico o specifico: Ad esempio, istruisci l'LLM per output solo 'corretto' o 'scorretto', o per giudicare su una scala da 1 a 5. Le valutazioni puramente qualitative sono difficili da valutare rapidamente e su larga scala.

- Incoraggia il ragionamento: Chiedi all'LLM di pensare prima di decidere un punteggio di valutazione, quindi scarta il ragionamento. Questo aumenta le prestazioni di valutazione, in particolare per compiti che richiedono giudizi complessi.

Passaggi successivi

Scopri come creare prompt che massimizzano i tuoi punteggi di eval.

Altri esempi di codice di eval valutate da umani, basate su codice e basate su LLM.

Was this page helpful?