Usando a Ferramenta de Avaliação

Acessando o Recurso de Avaliação

Para começar com a ferramenta de Avaliação:

- Abra o Console Claude e navegue até o editor de prompts.

- Após compor seu prompt, procure pela aba 'Evaluate' no topo da tela.

Certifique-se de que seu prompt inclua pelo menos 1-2 variáveis dinâmicas usando a sintaxe de chaves duplas: {{variável}}. Isso é necessário para criar conjuntos de teste de avaliação.

Gerando Prompts

O Console oferece um gerador de prompts integrado alimentado pelo Claude Opus 4.1:

Clique em 'Generate Prompt'

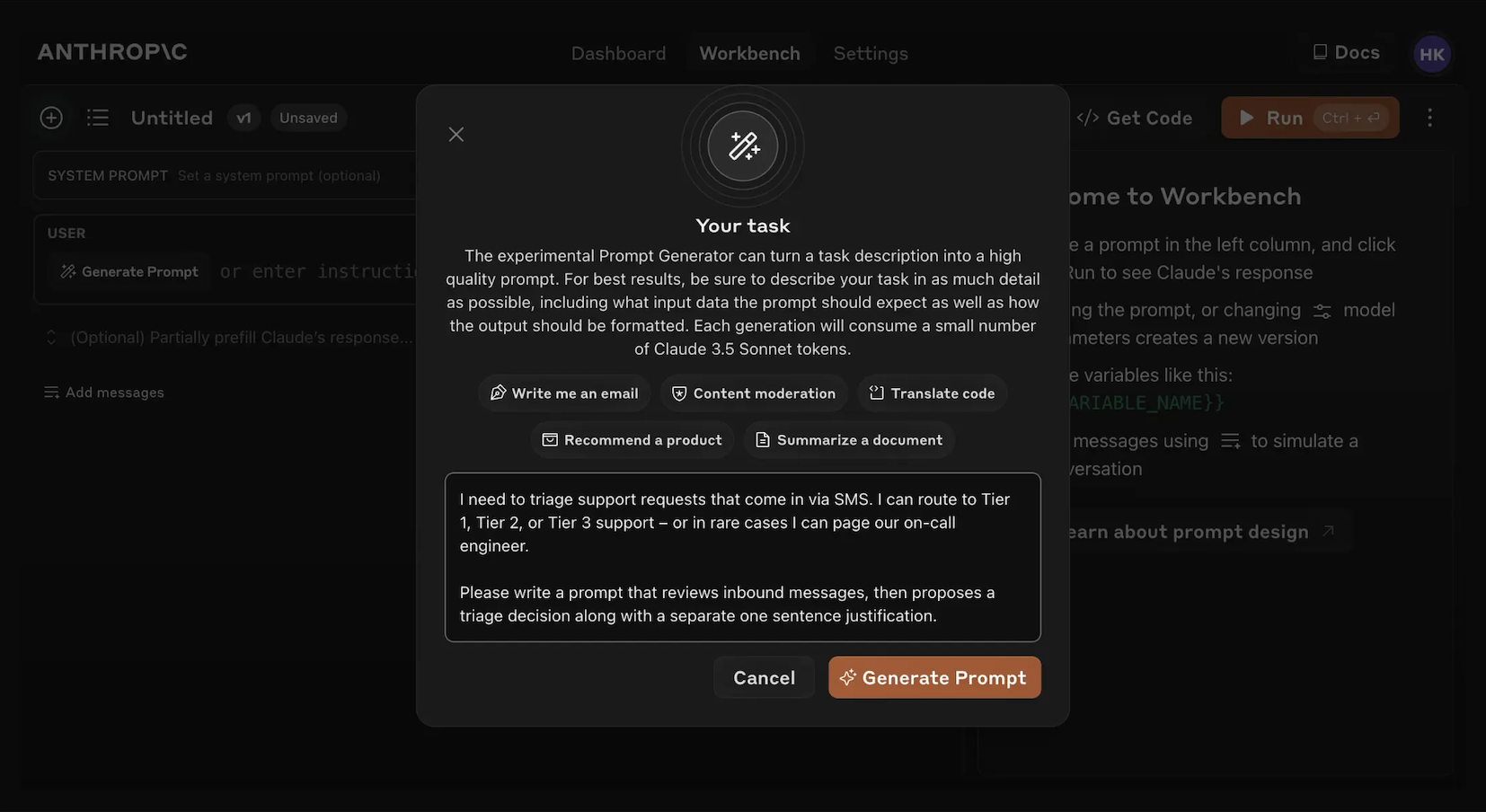

Clicar na ferramenta auxiliar 'Generate Prompt' abrirá um modal que permite inserir as informações da sua tarefa.

Descreva sua tarefa

Descreva sua tarefa desejada (por exemplo, "Fazer triagem de solicitações de suporte ao cliente recebidas") com tanto ou tão pouco detalhe quanto desejar. Quanto mais contexto você incluir, mais o Claude pode adaptar seu prompt gerado às suas necessidades específicas.

Gere seu prompt

Clicar no botão laranja 'Generate Prompt' na parte inferior fará com que o Claude gere um prompt de alta qualidade para você. Você pode então melhorar ainda mais esses prompts usando a tela de Avaliação no Console.

Este recurso facilita a criação de prompts com a sintaxe de variável apropriada para avaliação.

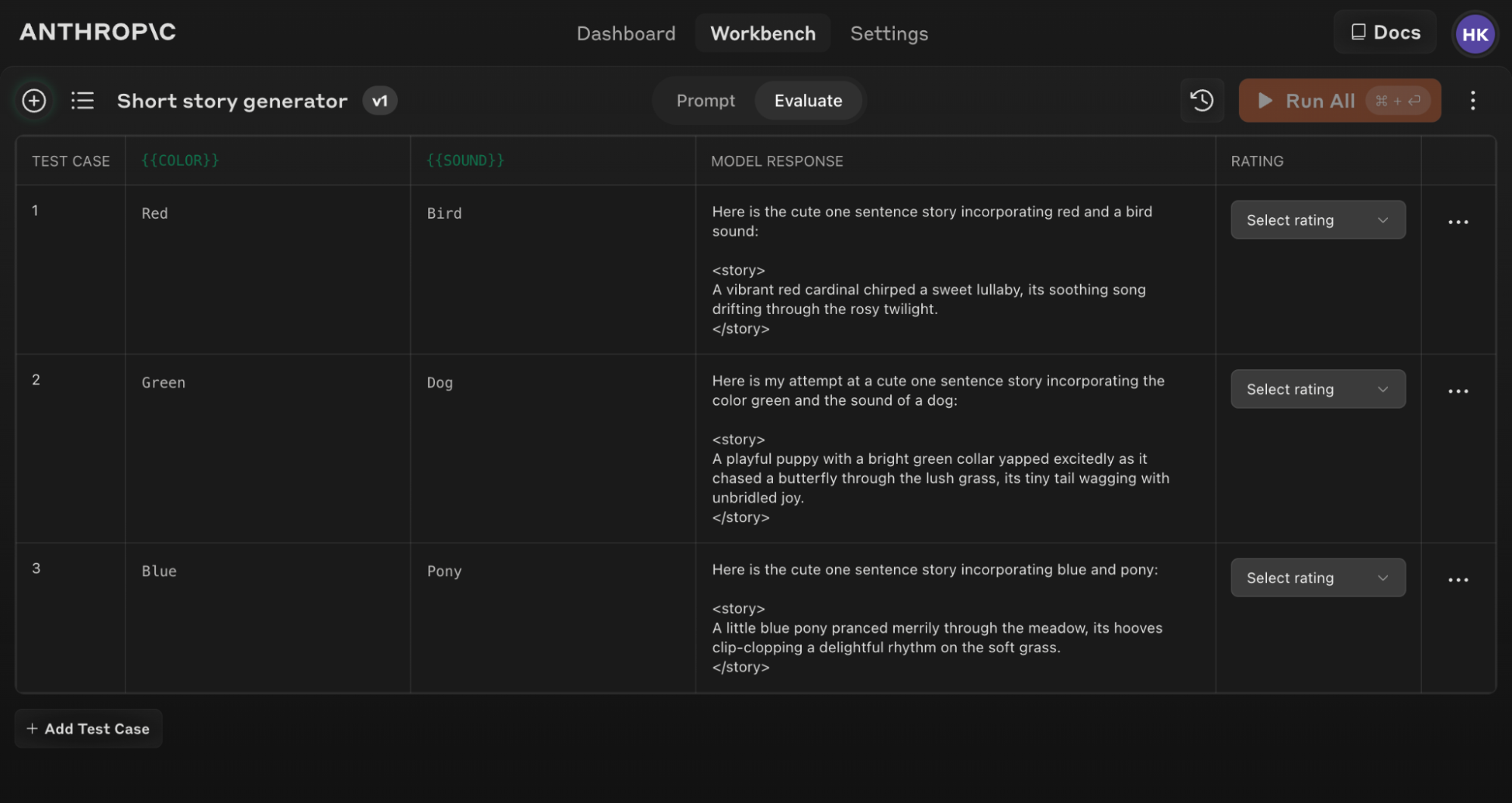

Criando Casos de Teste

Quando você acessa a tela de Avaliação, tem várias opções para criar casos de teste:

- Clique no botão '+ Add Row' no canto inferior esquerdo para adicionar manualmente um caso.

- Use o recurso 'Generate Test Case' para fazer com que o Claude gere automaticamente casos de teste para você.

- Importe casos de teste de um arquivo CSV.

Para usar o recurso 'Generate Test Case':

Clique em 'Generate Test Case'

O Claude gerará casos de teste para você, uma linha por vez para cada vez que você clicar no botão.

Edite a lógica de geração (opcional)

Você também pode editar a lógica de geração de casos de teste clicando na seta suspensa à direita do botão 'Generate Test Case', depois em 'Show generation logic' no topo da janela de Variáveis que aparece. Você pode ter que clicar em `Generate' no canto superior direito desta janela para popular a lógica de geração inicial.

Editar isso permite personalizar e ajustar finamente os casos de teste que o Claude gera com maior precisão e especificidade.

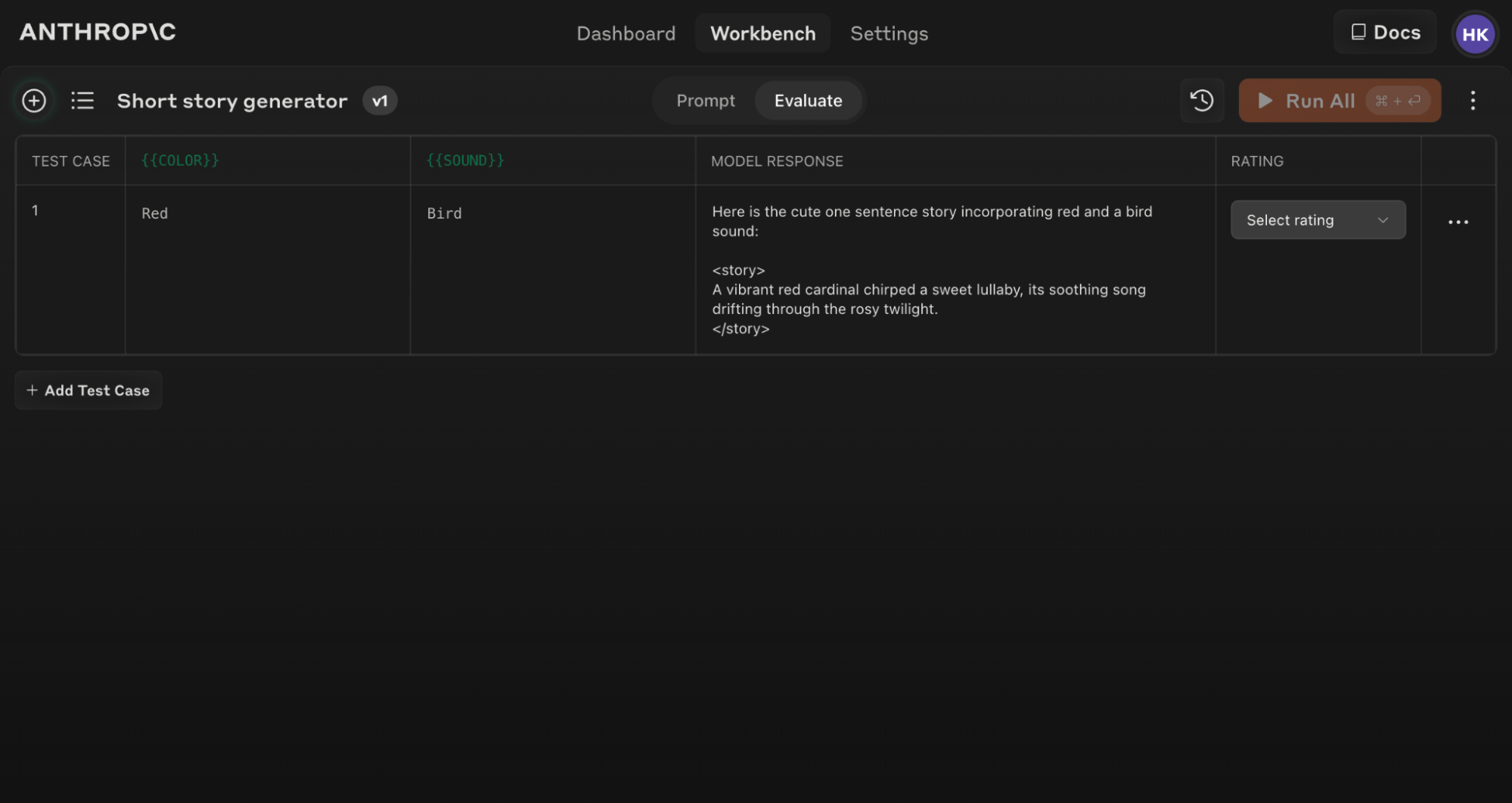

Aqui está um exemplo de uma tela de Avaliação populada com vários casos de teste:

Se você atualizar o texto do seu prompt original, pode executar novamente todo o conjunto de avaliação contra o novo prompt para ver como as mudanças afetam o desempenho em todos os casos de teste.

Dicas para Avaliação Eficaz

Use a ferramenta auxiliar 'Generate a prompt' no Console para criar rapidamente prompts com a sintaxe de variável apropriada para avaliação.

Entendendo e comparando resultados

A ferramenta de Avaliação oferece vários recursos para ajudá-lo a refinar seus prompts:

- Comparação lado a lado: Compare as saídas de dois ou mais prompts para ver rapidamente o impacto de suas mudanças.

- Classificação de qualidade: Classifique a qualidade da resposta em uma escala de 5 pontos para acompanhar melhorias na qualidade da resposta por prompt.

- Versionamento de prompt: Crie novas versões do seu prompt e execute novamente o conjunto de testes para iterar rapidamente e melhorar os resultados.

Ao revisar resultados em casos de teste e comparar diferentes versões de prompt, você pode identificar padrões e fazer ajustes informados ao seu prompt de forma mais eficiente.

Comece a avaliar seus prompts hoje para construir aplicações de IA mais robustas com o Claude!

Was this page helpful?