Criar avaliações empíricas fortes

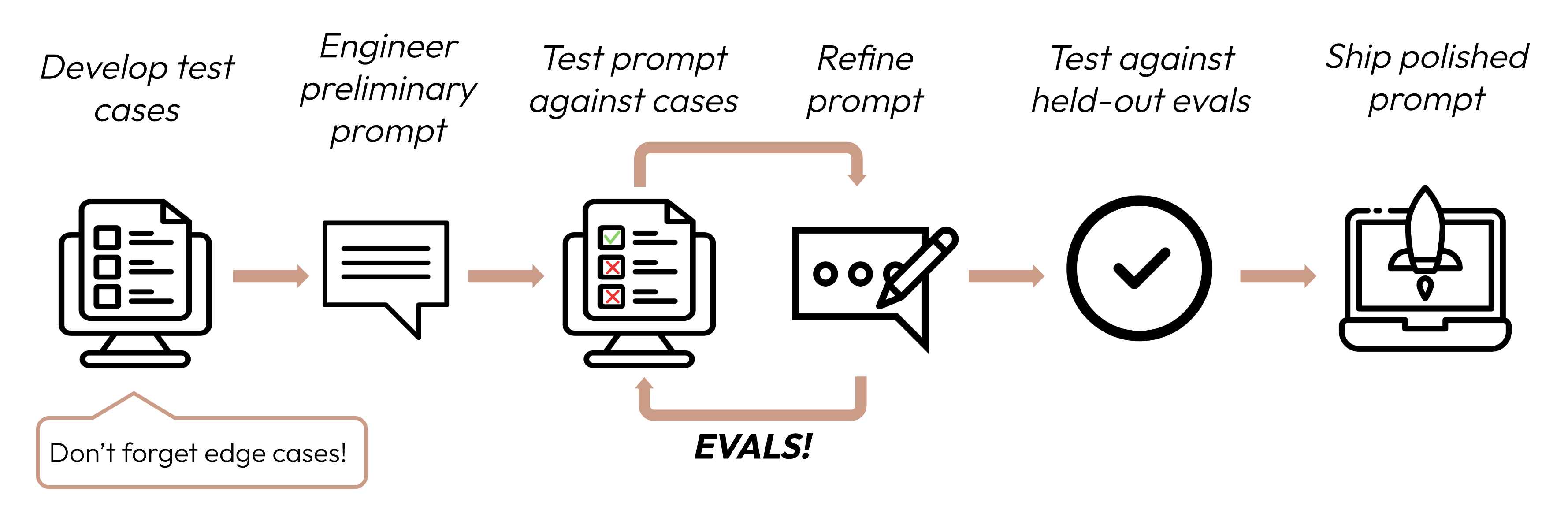

Após definir seus critérios de sucesso, o próximo passo é projetar avaliações para medir o desempenho do LLM em relação a esses critérios. Esta é uma parte vital do ciclo de engenharia de prompts.

Este guia se concentra em como desenvolver seus casos de teste.

Construindo evals e casos de teste

Princípios de design de eval

- Seja específico da tarefa: Projete evals que reflitam sua distribuição de tarefas do mundo real. Não se esqueça de considerar casos extremos!

- Automatize quando possível: Estruture perguntas para permitir classificação automatizada (por exemplo, múltipla escolha, correspondência de string, classificação por código, classificação por LLM).

- Priorize volume sobre qualidade: Mais perguntas com classificação automatizada de sinal ligeiramente inferior é melhor do que menos perguntas com evals de alta qualidade classificadas manualmente por humanos.

Evals de exemplo

Classificando evals

Ao decidir qual método usar para classificar evals, escolha o método mais rápido, mais confiável e mais escalável:

-

Classificação baseada em código: Mais rápida e confiável, extremamente escalável, mas também carece de nuances para julgamentos mais complexos que requerem menos rigidez baseada em regras.

- Correspondência exata:

output == golden_answer - Correspondência de string:

key_phrase in output

- Correspondência exata:

-

Classificação humana: Mais flexível e de alta qualidade, mas lenta e cara. Evite se possível.

-

Classificação baseada em LLM: Rápida e flexível, escalável e adequada para julgamentos complexos. Teste para garantir confiabilidade primeiro e depois dimensione.

Dicas para classificação baseada em LLM

- Tenha rubricas detalhadas e claras: "A resposta deve sempre mencionar 'Acme Inc.' na primeira frase. Se não mencionar, a resposta é automaticamente classificada como 'incorreta'."

Um caso de uso específico, ou até mesmo um critério de sucesso específico para esse caso de uso, pode exigir várias rubricas para avaliação holística.

- Empírico ou específico: Por exemplo, instrua o LLM a produzir apenas 'correto' ou 'incorreto', ou a julgar em uma escala de 1-5. Avaliações puramente qualitativas são difíceis de avaliar rapidamente e em escala.

- Incentive o raciocínio: Peça ao LLM para pensar primeiro antes de decidir uma pontuação de avaliação e depois descarte o raciocínio. Isso aumenta o desempenho da avaliação, particularmente para tarefas que exigem julgamento complexo.

Próximos passos

Aprenda como criar prompts que maximizem suas pontuações de eval.

Mais exemplos de código de evals classificadas por humanos, código e LLM.

Was this page helpful?