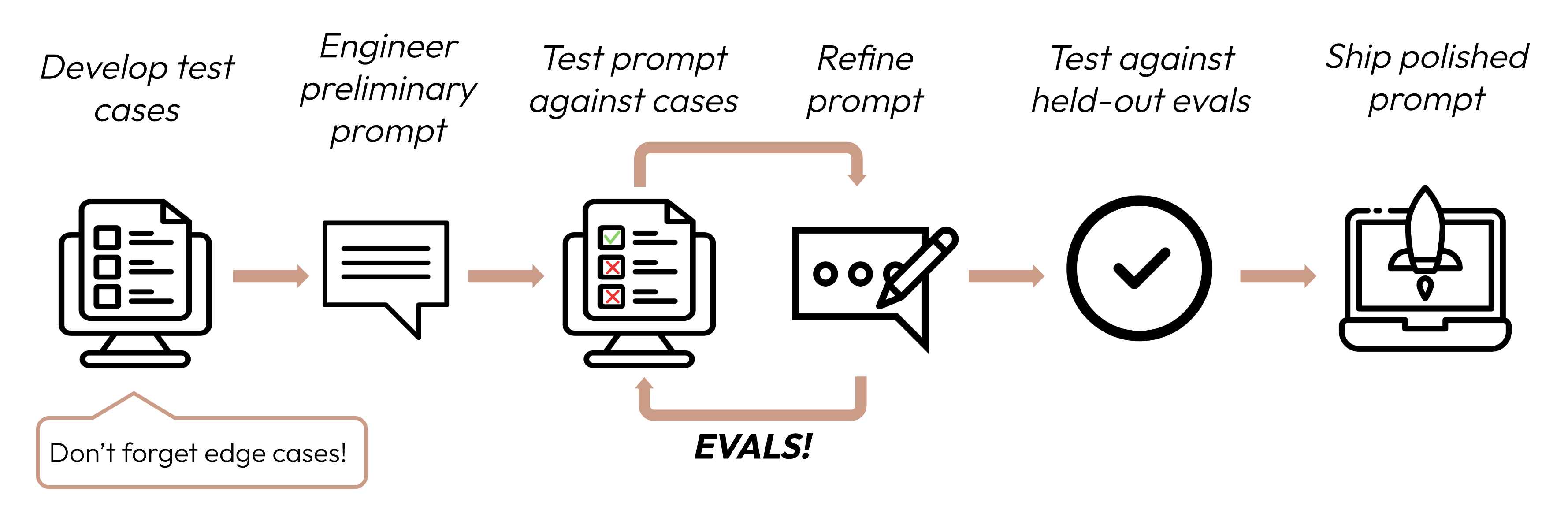

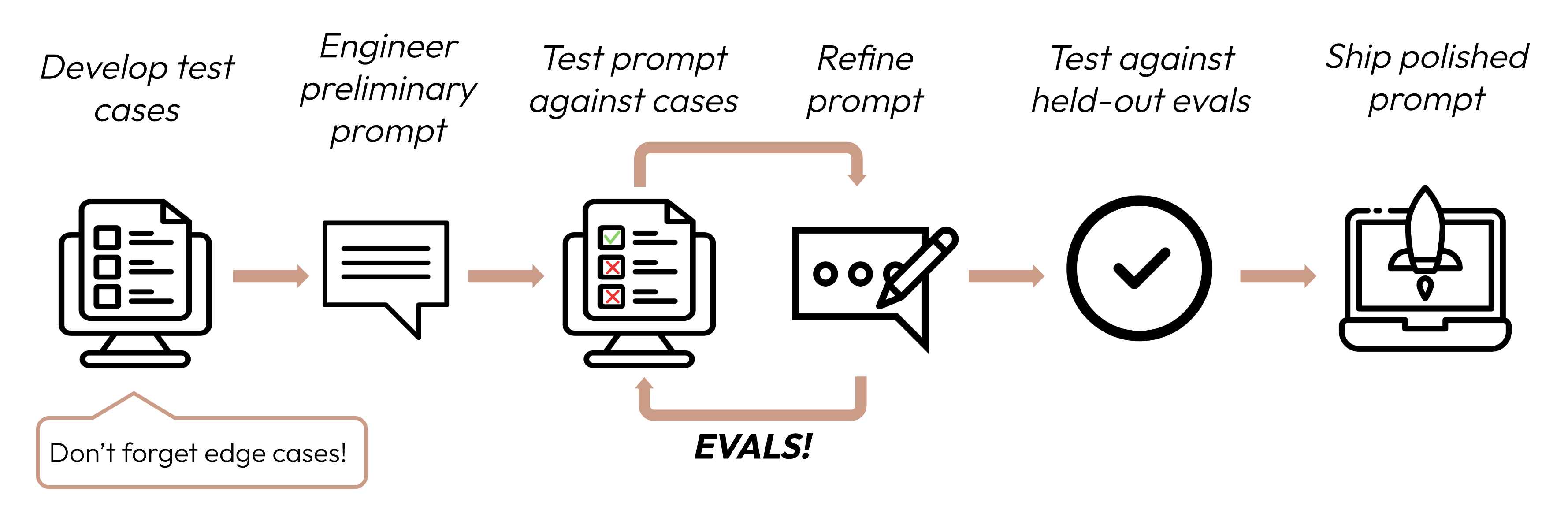

성공 기준을 정의한 후, 다음 단계는 해당 기준에 대한 LLM 성능을 측정하기 위한 평가를 설계하는 것입니다. 이것은 프롬프트 엔지니어링 사이클의 핵심적인 부분입니다.

이 가이드는 테스트 케이스를 개발하는 방법에 초점을 맞춥니다.

- 작업에 특화하기: 실제 작업 분포를 반영하는 평가를 설계하세요. 엣지 케이스도 고려하는 것을 잊지 마세요!

- 가능한 한 자동화하기: 자동 채점이 가능하도록 질문을 구조화하세요 (예: 객관식, 문자열 매칭, 코드 기반 채점, LLM 기반 채점).

- 품질보다 양 우선: 고품질 인간 수동 채점 평가의 적은 질문보다, 약간 낮은 신호의 자동 채점이라도 더 많은 질문이 낫습니다.

수백 개의 테스트 케이스를 수작업으로 작성하는 것은 어려울 수 있습니다! Claude에게 기본 예시 테스트 케이스 세트에서 더 많은 테스트 케이스를 생성하도록 도움을 요청하세요.

성공 기준을 평가하는 데 어떤 평가 방법이 유용할지 모르겠다면, Claude와 브레인스토밍할 수도 있습니다!

평가를 채점하는 방법을 결정할 때, 가장 빠르고, 가장 신뢰할 수 있으며, 가장 확장 가능한 방법을 선택하세요:

-

코드 기반 채점: 가장 빠르고 가장 신뢰할 수 있으며, 매우 확장 가능하지만, 규칙 기반의 엄격함보다 덜 엄격한 복잡한 판단에는 뉘앙스가 부족합니다.

- 정확 일치:

output == golden_answer

- 문자열 매칭:

key_phrase in output

-

인간 채점: 가장 유연하고 고품질이지만, 느리고 비용이 많이 듭니다. 가능하면 피하세요.

-

LLM 기반 채점: 빠르고 유연하며, 확장 가능하고 복잡한 판단에 적합합니다. 먼저 신뢰성을 테스트한 후 확장하세요.

- 상세하고 명확한 루브릭 작성: "답변은 항상 첫 번째 문장에서 'Acme Inc.'를 언급해야 합니다. 그렇지 않으면 답변은 자동으로 '오답'으로 채점됩니다."

주어진 사용 사례, 또는 해당 사용 사례의 특정 성공 기준에도 종합적인 평가를 위해 여러 루브릭이 필요할 수 있습니다.

- 경험적이거나 구체적으로: 예를 들어, LLM에게 'correct' 또는 'incorrect'만 출력하도록 지시하거나, 1-5 척도로 판단하도록 하세요. 순수하게 정성적인 평가는 빠르고 대규모로 평가하기 어렵습니다.

- 추론 장려: LLM에게 평가 점수를 결정하기 전에 먼저 생각하도록 요청한 다음, 추론 부분은 버리세요. 이는 특히 복잡한 판단이 필요한 작업에서 평가 성능을 향상시킵니다.