Menggunakan Alat Evaluasi

Mengakses Fitur Evaluate

Untuk memulai dengan alat Evaluasi:

- Buka Claude Console dan navigasikan ke editor prompt.

- Setelah menyusun prompt Anda, cari tab 'Evaluate' di bagian atas layar.

Pastikan prompt Anda menyertakan setidaknya 1-2 variabel dinamis menggunakan sintaks kurung kurawal ganda: {{variable}}. Ini diperlukan untuk membuat set tes eval.

Menghasilkan Prompt

Console menawarkan generator prompt bawaan yang didukung oleh Claude Opus 4.1:

Klik 'Generate Prompt'

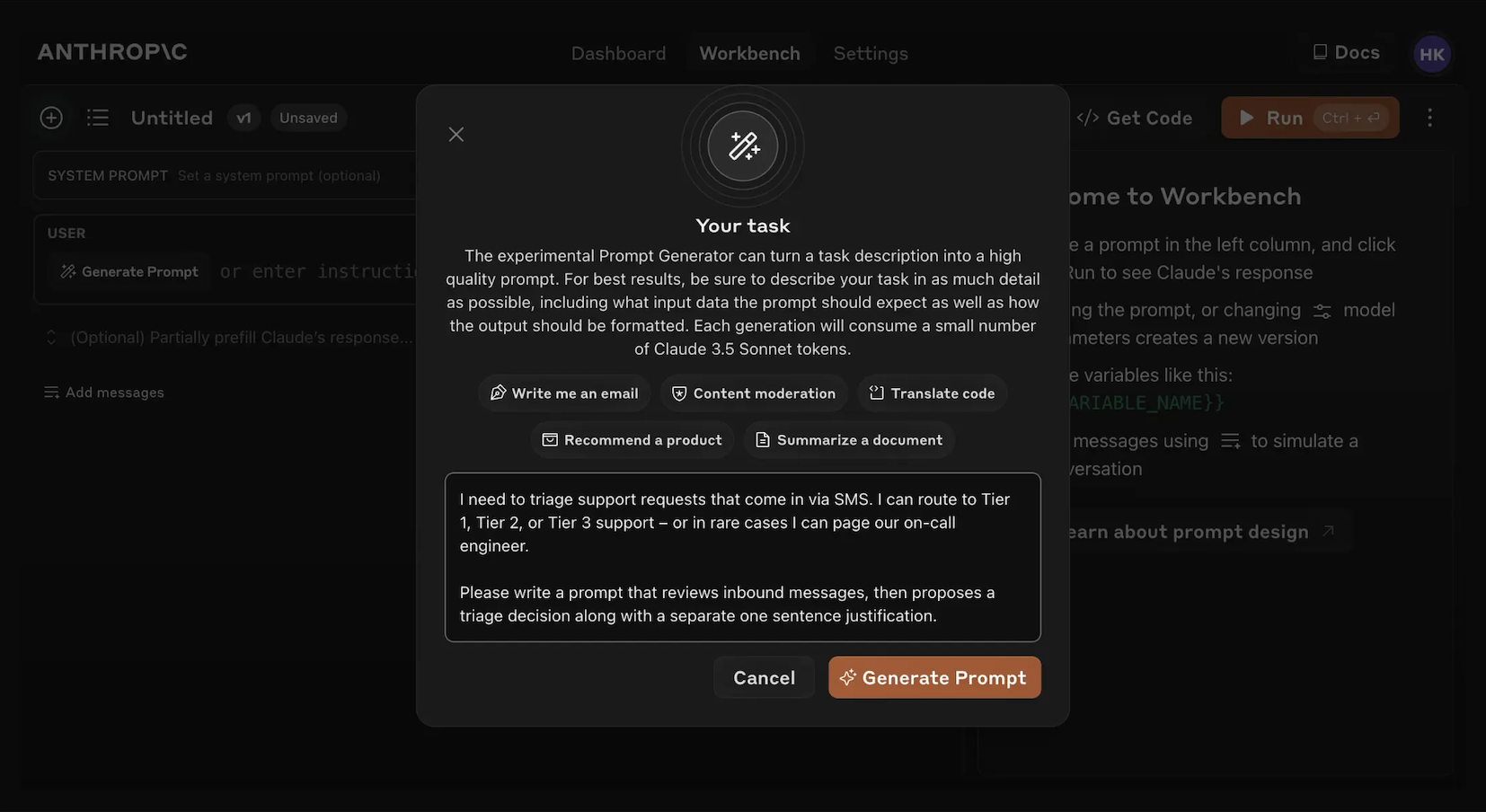

Mengklik alat bantu 'Generate Prompt' akan membuka modal yang memungkinkan Anda memasukkan informasi tugas Anda.

Deskripsikan tugas Anda

Deskripsikan tugas yang Anda inginkan (misalnya, "Triase permintaan dukungan pelanggan masuk") dengan detail sebanyak atau sesedikit yang Anda inginkan. Semakin banyak konteks yang Anda sertakan, semakin Claude dapat menyesuaikan prompt yang dihasilkannya dengan kebutuhan spesifik Anda.

Hasilkan prompt Anda

Mengklik tombol oranye 'Generate Prompt' di bagian bawah akan membuat Claude menghasilkan prompt berkualitas tinggi untuk Anda. Anda kemudian dapat lebih meningkatkan prompt tersebut menggunakan layar Evaluasi di Console.

Fitur ini memudahkan pembuatan prompt dengan sintaks variabel yang sesuai untuk evaluasi.

Membuat Kasus Uji

Ketika Anda mengakses layar Evaluasi, Anda memiliki beberapa opsi untuk membuat kasus uji:

- Klik tombol '+ Add Row' di kiri bawah untuk menambahkan kasus secara manual.

- Gunakan fitur 'Generate Test Case' untuk membuat Claude secara otomatis menghasilkan kasus uji untuk Anda.

- Impor kasus uji dari file CSV.

Untuk menggunakan fitur 'Generate Test Case':

Klik pada 'Generate Test Case'

Claude akan menghasilkan kasus uji untuk Anda, satu baris pada satu waktu untuk setiap kali Anda mengklik tombol.

Edit logika generasi (opsional)

Anda juga dapat mengedit logika generasi kasus uji dengan mengklik dropdown panah di sebelah kanan tombol 'Generate Test Case', kemudian pada 'Show generation logic' di bagian atas jendela Variables yang muncul. Anda mungkin harus mengklik `Generate' di kanan atas jendela ini untuk mengisi logika generasi awal.

Mengedit ini memungkinkan Anda menyesuaikan dan menyempurnakan kasus uji yang dihasilkan Claude dengan presisi dan spesifisitas yang lebih besar.

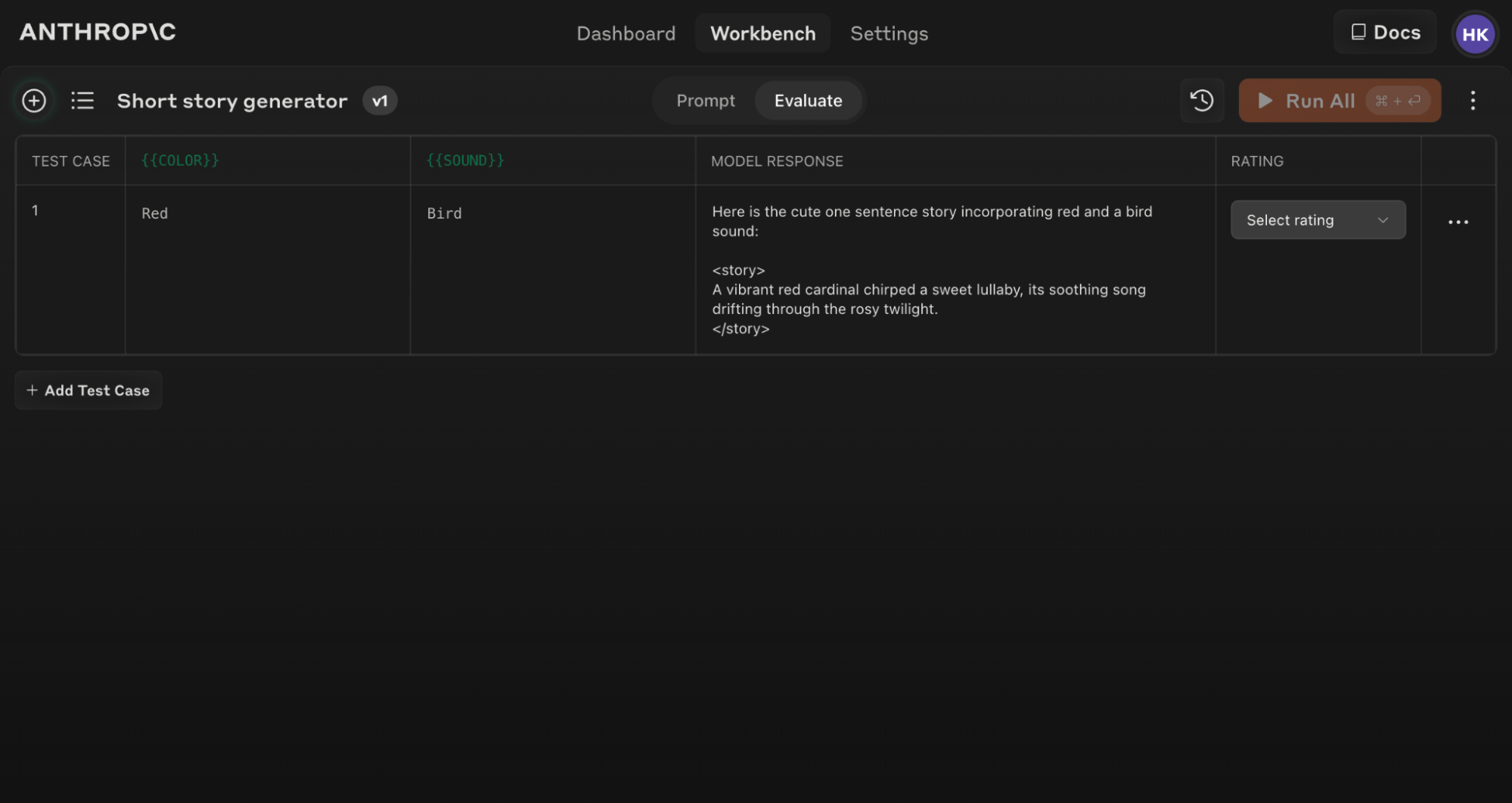

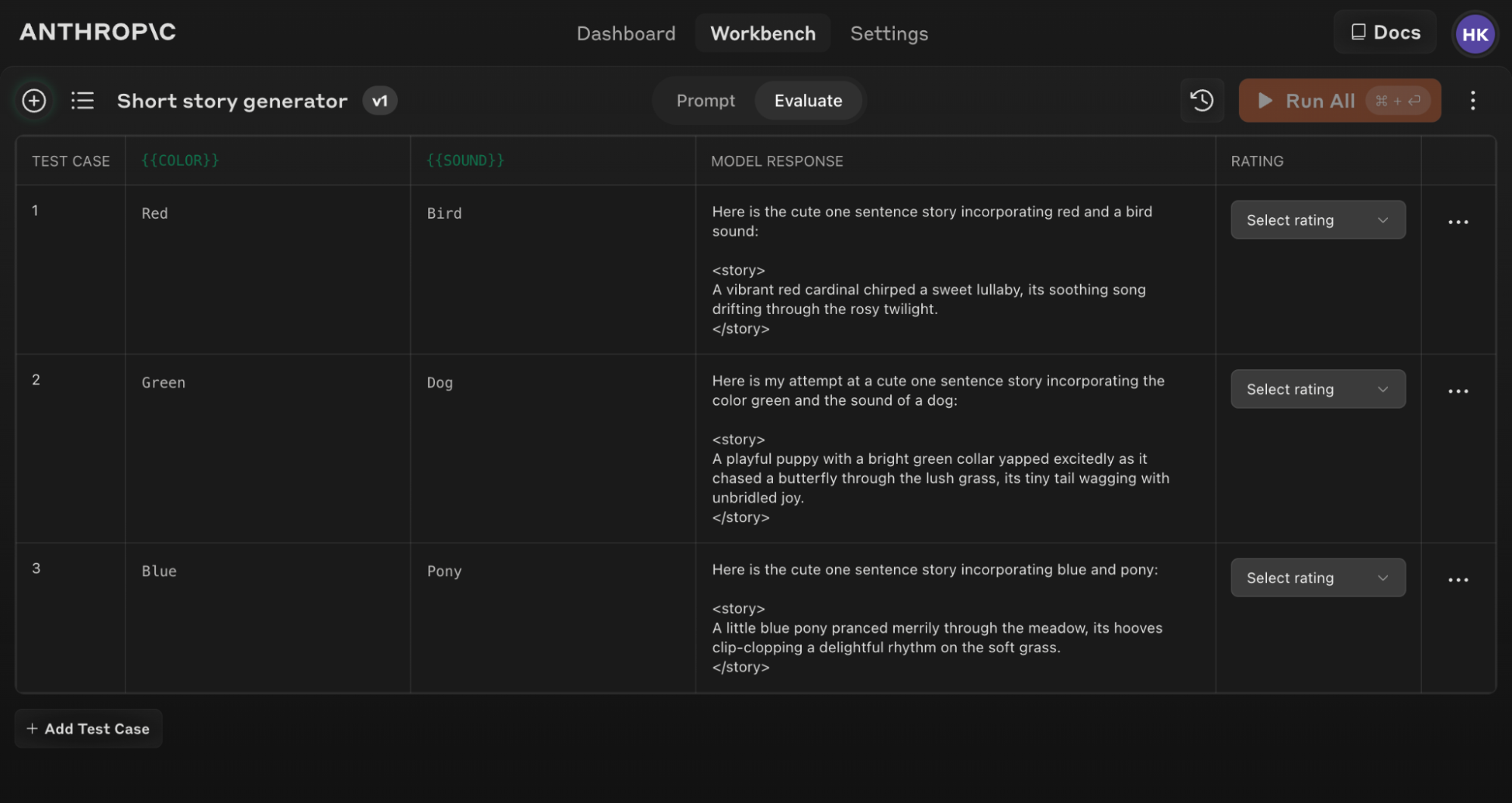

Berikut adalah contoh layar Evaluasi yang terisi dengan beberapa kasus uji:

Jika Anda memperbarui teks prompt asli Anda, Anda dapat menjalankan ulang seluruh rangkaian eval terhadap prompt baru untuk melihat bagaimana perubahan mempengaruhi kinerja di semua kasus uji.

Tips untuk Evaluasi yang Efektif

Gunakan alat bantu 'Generate a prompt' di Console untuk dengan cepat membuat prompt dengan sintaks variabel yang sesuai untuk evaluasi.

Memahami dan membandingkan hasil

Alat Evaluasi menawarkan beberapa fitur untuk membantu Anda menyempurnakan prompt Anda:

- Perbandingan berdampingan: Bandingkan output dari dua atau lebih prompt untuk dengan cepat melihat dampak perubahan Anda.

- Penilaian kualitas: Nilai kualitas respons pada skala 5 poin untuk melacak peningkatan kualitas respons per prompt.

- Versioning prompt: Buat versi baru dari prompt Anda dan jalankan ulang rangkaian tes untuk dengan cepat beriterasi dan meningkatkan hasil.

Dengan meninjau hasil di seluruh kasus uji dan membandingkan versi prompt yang berbeda, Anda dapat melihat pola dan membuat penyesuaian yang tepat pada prompt Anda dengan lebih efisien.

Mulai evaluasi prompt Anda hari ini untuk membangun aplikasi AI yang lebih kuat dengan Claude!

Was this page helpful?