Crear evaluaciones empíricas sólidas

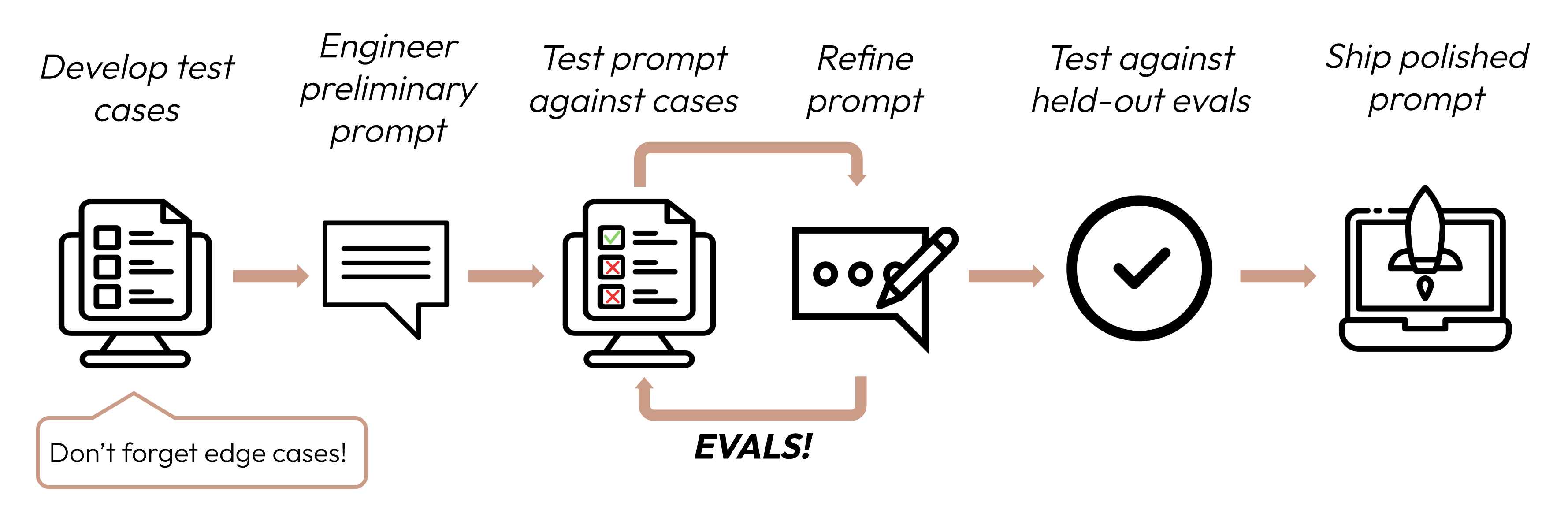

Después de definir tus criterios de éxito, el siguiente paso es diseñar evaluaciones para medir el rendimiento del LLM contra esos criterios. Esta es una parte vital del ciclo de ingeniería de prompts.

Esta guía se enfoca en cómo desarrollar tus casos de prueba.

Construir evals y casos de prueba

Principios de diseño de eval

- Sé específico de la tarea: Diseña evals que reflejen tu distribución de tareas del mundo real. ¡No olvides factorizar los casos límite!

- Automatiza cuando sea posible: Estructura preguntas para permitir calificación automatizada (por ejemplo, opción múltiple, coincidencia de cadena, calificación de código, calificación por LLM).

- Prioriza volumen sobre calidad: Más preguntas con calificación automatizada de señal ligeramente más baja es mejor que menos preguntas con evals de alta calidad calificadas manualmente por humanos.

Evals de ejemplo

Calificar evals

Al decidir qué método usar para calificar evals, elige el método más rápido, más confiable y más escalable:

-

Calificación basada en código: La más rápida y confiable, extremadamente escalable, pero también carece de matices para juicios más complejos que requieren menos rigidez basada en reglas.

- Coincidencia exacta:

output == golden_answer - Coincidencia de cadena:

key_phrase in output

- Coincidencia exacta:

-

Calificación humana: La más flexible y de alta calidad, pero lenta y cara. Evita si es posible.

-

Calificación basada en LLM: Rápida y flexible, escalable y adecuada para juicios complejos. Prueba primero para asegurar confiabilidad y luego escala.

Consejos para calificación basada en LLM

- Ten rúbricas detalladas y claras: "La respuesta siempre debe mencionar 'Acme Inc.' en la primera oración. Si no lo hace, la respuesta se califica automáticamente como 'incorrecta'."

Un caso de uso dado, o incluso un criterio de éxito específico para ese caso de uso, podría requerir varias rúbricas para una evaluación holística.

- Empírico o específico: Por ejemplo, instruye al LLM para que genere solo 'correcto' o 'incorrecto', o para que juzgue en una escala del 1 al 5. Las evaluaciones puramente cualitativas son difíciles de evaluar rápidamente y a escala.

- Fomenta el razonamiento: Pide al LLM que piense primero antes de decidir una puntuación de evaluación, y luego descarta el razonamiento. Esto aumenta el rendimiento de la evaluación, particularmente para tareas que requieren juicio complejo.

Próximos pasos

Aprende cómo crear prompts que maximicen tus puntuaciones de eval.

Más ejemplos de código de evals calificadas por humanos, código y LLM.

Was this page helpful?