チケットルーティング

チケットルーティングにClaudeを使用すべきかどうかを判断する

分類タスクに従来のMLアプローチではなく、ClaudeのようなLLMを使用すべき主な指標を以下に示します:

LLMサポートワークフローの構築とデプロイ

現在のサポートアプローチを理解する

自動化に取り組む前に、既存のチケットシステムを理解することが重要です。まず、サポートチームが現在どのようにチケットルーティングを処理しているかを調査しましょう。

以下のような質問を検討してください:

- どのSLA/サービス提供が適用されるかを決定するために、どのような基準が使用されていますか?

- チケットルーティングは、チケットがどのティアのサポートまたは製品スペシャリストに送られるかを決定するために使用されていますか?

- すでに自動化されたルールやワークフローはありますか?どのような場合に失敗しますか?

- エッジケースや曖昧なチケットはどのように処理されていますか?

- チームはチケットをどのように優先順位付けしていますか?

人間が特定のケースをどのように処理しているかを知れば知るほど、Claudeにそのタスクを実行させるための作業がうまくいきます。

ユーザーインテントカテゴリを定義する

明確に定義されたユーザーインテントカテゴリのリストは、Claudeによる正確なサポートチケット分類に不可欠です。Claudeがシステム内でチケットを効果的にルーティングする能力は、システムのカテゴリがどれだけ明確に定義されているかに直接比例します。

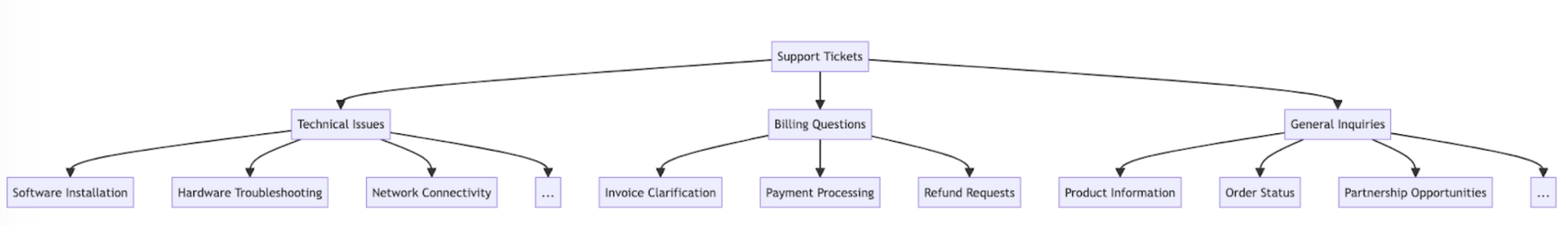

以下にユーザーインテントカテゴリとサブカテゴリの例を示します。

インテントに加えて、チケットのルーティングと優先順位付けは、緊急度、顧客タイプ、SLA、言語などの他の要因にも影響される場合があります。自動ルーティングシステムを構築する際には、他のルーティング基準も考慮してください。

成功基準を確立する

サポートチームと協力して、測定可能なベンチマーク、閾値、目標を含む明確な成功基準を定義してください。

LLMをサポートチケットルーティングに使用する際の標準的な基準とベンチマークを以下に示します:

LLMの使用に関係なく有用な一般的な成功基準を以下に示します:

適切なClaudeモデルを選択する

モデルの選択は、コスト、精度、応答時間のトレードオフに依存します。

多くのお客様が、claude-haiku-4-5-20251001をチケットルーティングに理想的なモデルと評価しています。これはClaude 4ファミリーの中で最も高速でコスト効率の良いモデルでありながら、優れた結果を提供するためです。分類問題に深い専門知識や大量のインテントカテゴリの複雑な推論が必要な場合は、より大きなSonnetモデルを選択することもできます。

強力なプロンプトを構築する

チケットルーティングは分類タスクの一種です。Claudeはサポートチケットの内容を分析し、問題の種類、緊急度、必要な専門知識、またはその他の関連要因に基づいて、事前定義されたカテゴリに分類します。

チケット分類プロンプトを作成しましょう。最初のプロンプトには、ユーザーリクエストの内容を含め、推論とインテントの両方を返すようにします。

Claude Consoleのプロンプトジェネレーターを試して、Claudeに最初のドラフトを作成してもらいましょう。

以下はチケットルーティング分類プロンプトの例です:

def classify_support_request(ticket_contents):

# Define the prompt for the classification task

classification_prompt = f"""You will be acting as a customer support ticket classification system. Your task is to analyze customer support requests and output the appropriate classification intent for each request, along with your reasoning.

Here is the customer support request you need to classify:

<request>{ticket_contents}</request>

Please carefully analyze the above request to determine the customer's core intent and needs. Consider what the customer is asking for has concerns about.

First, write out your reasoning and analysis of how to classify this request inside <reasoning> tags.

Then, output the appropriate classification label for the request inside a <intent> tag. The valid intents are:

<intents>

<intent>Support, Feedback, Complaint</intent>

<intent>Order Tracking</intent>

<intent>Refund/Exchange</intent>

</intents>

A request may have ONLY ONE applicable intent. Only include the intent that is most applicable to the request.

As an example, consider the following request:

<request>Hello! I had high-speed fiber internet installed on Saturday and my installer, Kevin, was absolutely fantastic! Where can I send my positive review? Thanks for your help!</request>

Here is an example of how your output should be formatted (for the above example request):

<reasoning>The user seeks information in order to leave positive feedback.</reasoning>

<intent>Support, Feedback, Complaint</intent>

Here are a few more examples:

<examples>

<example 2>

Example 2 Input:

<request>I wanted to write and personally thank you for the compassion you showed towards my family during my father's funeral this past weekend. Your staff was so considerate and helpful throughout this whole process; it really took a load off our shoulders. The visitation brochures were beautiful. We'll never forget the kindness you showed us and we are so appreciative of how smoothly the proceedings went. Thank you, again, Amarantha Hill on behalf of the Hill Family.</request>

Example 2 Output:

<reasoning>User leaves a positive review of their experience.</reasoning>

<intent>Support, Feedback, Complaint</intent>

</example 2>

<example 3>

...

</example 8>

<example 9>

Example 9 Input:

<request>Your website keeps sending ad-popups that block the entire screen. It took me twenty minutes just to finally find the phone number to call and complain. How can I possibly access my account information with all of these popups? Can you access my account for me, since your website is broken? I need to know what the address is on file.</request>

Example 9 Output:

<reasoning>The user requests help accessing their web account information.</reasoning>

<intent>Support, Feedback, Complaint</intent>

</example 9>

Remember to always include your classification reasoning before your actual intent output. The reasoning should be enclosed in <reasoning> tags and the intent in <intent> tags. Return only the reasoning and the intent.

"""このプロンプトの主要なコンポーネントを分解してみましょう:

- Python f-stringを使用してプロンプトテンプレートを作成し、

ticket_contentsを<request>タグに挿入できるようにしています。 - Claudeに、チケットの内容を慎重に分析して顧客のコアインテントとニーズを判断する分類システムとしての明確に定義された役割を与えています。

- Claudeに適切な出力フォーマットを指示しています。この場合、

<reasoning>タグ内に推論と分析を提供し、続いて<intent>タグ内に適切な分類ラベルを提供するようにしています。 - 有効なインテントカテゴリを指定しています:「Support, Feedback, Complaint」、「Order Tracking」、「Refund/Exchange」。

- 出力のフォーマット方法を示すいくつかの例(few-shotプロンプティング)を含めており、精度と一貫性を向上させています。

Claudeの応答をさまざまなXMLタグセクションに分割させる理由は、正規表現を使用して出力から推論とインテントを個別に抽出できるようにするためです。これにより、チケットルーティングワークフローでターゲットを絞った次のステップを作成できます。例えば、インテントのみを使用してチケットをルーティングする相手を決定するなどです。

プロンプトをデプロイする

テスト本番環境にデプロイして評価を実行しないと、プロンプトがどれだけうまく機能するかを知ることは困難です。

デプロイメント構造を構築しましょう。まず、Claudeへの呼び出しをラップするためのメソッドシグネチャを定義します。すでに書き始めたメソッドを使用し、ticket_contentsを入力として、reasoningとintentのタプルを出力として返すようにします。従来のMLを使用した既存の自動化がある場合は、そのメソッドシグネチャに従ってください。

import anthropic

import re

# Create an instance of the Claude API client

client = anthropic.Anthropic()

# Set the default model

DEFAULT_MODEL="claude-haiku-4-5-20251001"

def classify_support_request(ticket_contents):

# Define the prompt for the classification task

classification_prompt = f"""You will be acting as a customer support ticket classification system.

...

... The reasoning should be enclosed in <reasoning> tags and the intent in <intent> tags. Return only the reasoning and the intent.

"""

# Send the prompt to the API to classify the support request.

message = client.messages.create(

model=DEFAULT_MODEL,

max_tokens=500,

temperature=0,

messages=[{"role": "user", "content": classification_prompt}],

stream=False,

)

reasoning_and_intent = message.content[0].text

# Use Python's regular expressions library to extract `reasoning`.

reasoning_match = re.search(

r"<reasoning>(.*?)</reasoning>", reasoning_and_intent, re.DOTALL

)

reasoning = reasoning_match.group(1).strip() if reasoning_match else ""

# Similarly, also extract the `intent`.

intent_match = re.search(r"<intent>(.*?)</intent>", reasoning_and_intent, re.DOTALL)

intent = intent_match.group(1).strip() if intent_match else ""

return reasoning, intentこのコードは:

- Anthropicライブラリをインポートし、APIキーを使用してクライアントインスタンスを作成します。

ticket_contents文字列を受け取るclassify_support_request関数を定義します。classification_promptを使用してticket_contentsをClaudeに送信して分類します。- レスポンスから抽出されたモデルの

reasoningとintentを返します。

推論とインテントのテキスト全体が生成されるのを待ってからパースする必要があるため、stream=False(デフォルト)に設定しています。

プロンプトを評価する

プロンプティングは、本番環境に対応するためにテストと最適化が必要になることが多いです。ソリューションの準備状況を判断するには、先に確立した成功基準と閾値に基づいてパフォーマンスを評価してください。

評価を実行するには、実行するためのテストケースが必要です。このガイドの残りの部分では、すでにテストケースを開発済みであることを前提としています。

評価関数を構築する

このガイドの評価例では、Claudeのパフォーマンスを3つの主要な指標で測定します:

- 精度

- 分類あたりのコスト

重要な要因に応じて、他の軸でもClaudeを評価する必要があるかもしれません。

これを評価するには、まず作成したスクリプトを修正し、予測されたインテントと実際のインテントを比較して正しい予測の割合を計算する関数を追加する必要があります。また、コスト計算と時間測定の機能も追加する必要があります。

import anthropic

import re

# Create an instance of the Claude API client

client = anthropic.Anthropic()

# Set the default model

DEFAULT_MODEL="claude-haiku-4-5-20251001"

def classify_support_request(request, actual_intent):

# Define the prompt for the classification task

classification_prompt = f"""You will be acting as a customer support ticket classification system.

...

...The reasoning should be enclosed in <reasoning> tags and the intent in <intent> tags. Return only the reasoning and the intent.

"""

message = client.messages.create(

model=DEFAULT_MODEL,

max_tokens=500,

temperature=0,

messages=[{"role": "user", "content": classification_prompt}],

)

usage = message.usage # Get the usage statistics for the API call for how many input and output tokens were used.

reasoning_and_intent = message.content[0].text

# Use Python's regular expressions library to extract `reasoning`.

reasoning_match = re.search(

r"<reasoning>(.*?)</reasoning>", reasoning_and_intent, re.DOTALL

)

reasoning = reasoning_match.group(1).strip() if reasoning_match else ""

# Similarly, also extract the `intent`.

intent_match = re.search(r"<intent>(.*?)</intent>", reasoning_and_intent, re.DOTALL)

intent = intent_match.group(1).strip() if intent_match else ""

# Check if the model's prediction is correct.

correct = actual_intent.strip() == intent.strip()

# Return the reasoning, intent, correct, and usage.

return reasoning, intent, correct, usage行った編集を分解してみましょう:

- テストケースからの

actual_intentをclassify_support_requestメソッドに追加し、Claudeのインテント分類がゴールデンインテント分類と一致するかどうかを評価するための比較を設定しました。 - 使用された入力トークンと出力トークンに基づいてコストを計算するために、API呼び出しの使用統計を抽出しました。

評価を実行する

適切な評価には、良い結果とは何かを判断するための明確な閾値とベンチマークが必要です。上記のスクリプトは精度、応答時間、分類あたりのコストのランタイム値を提供しますが、明確に確立された閾値がまだ必要です。例えば:

- 精度: 95%(100テスト中)

- 分類あたりのコスト: 現在のルーティング方法から平均50%削減(100テスト全体)

これらの閾値があることで、大規模に、かつ公平な実証主義で、どの方法が最適か、要件により適合するためにどのような変更が必要かを迅速かつ容易に判断できます。

パフォーマンスを改善する

複雑なシナリオでは、標準的なプロンプトエンジニアリング手法やガードレール実装戦略を超えて、パフォーマンスを改善するための追加戦略を検討することが有用な場合があります。以下に一般的なシナリオを示します:

20以上のインテントカテゴリがある場合は分類階層を使用する

クラスの数が増えるにつれて、必要な例の数も増加し、プロンプトが扱いにくくなる可能性があります。代替として、分類器の混合を使用した階層的分類システムの実装を検討できます。

- インテントを分類階層のツリー構造で整理します。

- ツリーの各レベルに一連の分類器を作成し、カスケードルーティングアプローチを可能にします。

例えば、チケットを「技術的な問題」、「請求に関する質問」、「一般的な問い合わせ」に大まかに分類するトップレベルの分類器を持つことができます。これらの各カテゴリには、分類をさらに精緻化するための独自のサブ分類器を持たせることができます。

-

メリット - より高いニュアンスと精度: 各親パスに対して異なるプロンプトを作成でき、よりターゲットを絞ったコンテキスト固有の分類が可能になります。これにより、精度が向上し、顧客リクエストのより繊細な処理が可能になります。

-

デメリット - レイテンシの増加: 複数の分類器はレイテンシの増加につながる可能性があるため、最速のモデルであるHaikuでこのアプローチを実装することをお勧めします。

高度に変動するチケットを処理するためにベクトルデータベースと類似性検索を使用する

例を提供することがパフォーマンスを改善する最も効果的な方法であるにもかかわらず、サポートリクエストが高度に変動する場合、単一のプロンプトに十分な例を含めることが困難な場合があります。

このシナリオでは、ベクトルデータベースを使用して例のデータセットから類似性検索を行い、特定のクエリに最も関連性の高い例を取得することができます。

このアプローチは、分類レシピで詳しく説明されており、精度を71%から93%に改善することが示されています。

予想されるエッジケースに具体的に対処する

Claudeがチケットを誤分類する可能性のあるシナリオを以下に示します(あなたの状況に固有の他のケースもあるかもしれません)。これらのシナリオでは、Claudeがエッジケースをどのように処理すべきかについて、プロンプトに明示的な指示や例を提供することを検討してください:

Claudeをより大きなサポートワークフローに統合する

適切な統合には、Claudeベースのチケットルーティングスクリプトがより大きなチケットルーティングシステムのアーキテクチャにどのように適合するかについて、いくつかの決定を行う必要があります。これを行う方法は2つあります:

- プッシュベース: 使用しているサポートチケットシステム(例:Zendesk)がWebhookイベントをルーティングサービスに送信してコードをトリガーし、インテントを分類してルーティングします。

- このアプローチはWebスケーラビリティに優れていますが、パブリックエンドポイントを公開する必要があります。

- プルベース: コードが指定されたスケジュールに基づいて最新のチケットをプルし、プル時にルーティングします。

- このアプローチは実装が容易ですが、プル頻度が高すぎるとサポートチケットシステムへの不要な呼び出しが発生したり、プル頻度が低すぎると過度に遅くなったりする可能性があります。

これらのアプローチのいずれかについて、スクリプトをサービスにラップする必要があります。アプローチの選択は、サポートチケットシステムが提供するAPIに依存します。

より多くのサンプルコードと詳細な評価ガイダンスについては、分類クックブックをご覧ください。

Claude Consoleでワークフローの構築と評価を始めましょう。

Was this page helpful?