Define si usar Claude para enrutamiento de tickets

Aquí hay algunos indicadores clave de que deberías usar un LLM como Claude en lugar de enfoques tradicionales de ML para tu tarea de clasificación:

Construye e implementa tu flujo de trabajo de soporte LLM

Comprende tu enfoque de soporte actual

Antes de sumergirte en la automatización, es crucial entender tu sistema de tickets existente. Comienza investigando cómo tu equipo de soporte actualmente maneja el enrutamiento de tickets.

Considera preguntas como:

- ¿Qué criterios se utilizan para determinar qué SLA/oferta de servicio se aplica?

- ¿Se utiliza el enrutamiento de tickets para determinar a qué nivel de soporte o especialista de producto va un ticket?

- ¿Hay alguna regla automatizada o flujos de trabajo ya en lugar? ¿En qué casos fallan?

- ¿Cómo se manejan los casos extremos o tickets ambiguos?

- ¿Cómo el equipo prioriza los tickets?

Cuanto más sepas sobre cómo los humanos manejan ciertos casos, mejor podrás trabajar con Claude para hacer la tarea.

Define categorías de intención del usuario

Una lista bien definida de categorías de intención del usuario es crucial para una clasificación precisa de tickets de soporte con Claude. La capacidad de Claude para enrutar tickets efectivamente dentro de tu sistema es directamente proporcional a qué tan bien definidas estén las categorías de tu sistema.

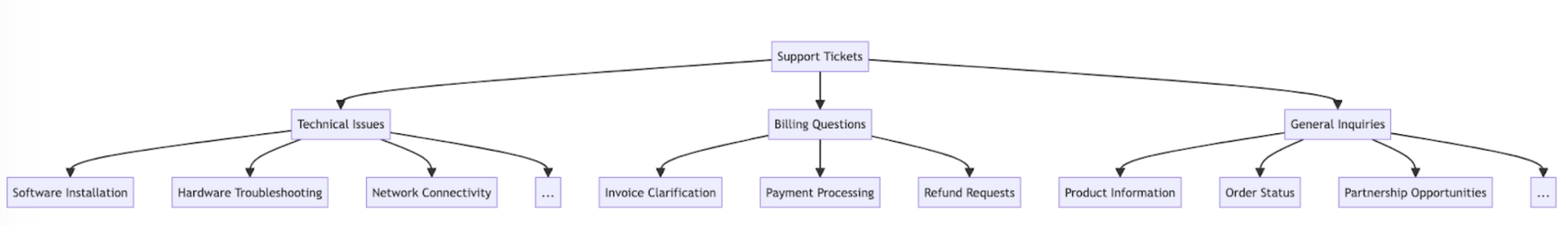

Aquí hay algunas categorías de intención del usuario de ejemplo y subcategorías.

Además de la intención, el enrutamiento y la priorización de tickets también pueden ser influenciados por otros factores como urgencia, tipo de cliente, SLA o idioma. Asegúrate de considerar otros criterios de enrutamiento al construir tu sistema de enrutamiento automatizado.

Establece criterios de éxito

Trabaja con tu equipo de soporte para definir criterios de éxito claros con puntos de referencia medibles, umbrales y objetivos.

Aquí hay algunos criterios estándar y puntos de referencia al usar LLM para enrutamiento de tickets de soporte:

Aquí hay algunos criterios de éxito comunes que pueden ser útiles independientemente de si se usa un LLM:

Elige el modelo Claude correcto

La elección del modelo depende de los compromisos entre costo, precisión y tiempo de respuesta.

Muchos clientes han encontrado que claude-haiku-4-5-20251001 es un modelo ideal para enrutamiento de tickets, ya que es el modelo más rápido y rentable de la familia Claude 4 mientras sigue ofreciendo excelentes resultados. Si tu problema de clasificación requiere experiencia profunda en la materia o un gran volumen de categorías de intención con razonamiento complejo, puedes optar por el modelo Sonnet más grande.

Construye un prompt fuerte

El enrutamiento de tickets es un tipo de tarea de clasificación. Claude analiza el contenido de un ticket de soporte y lo clasifica en categorías predefinidas basándose en el tipo de problema, urgencia, experiencia requerida u otros factores relevantes.

Escribamos un prompt de clasificación de tickets. Nuestro prompt inicial debe contener el contenido de la solicitud del usuario y devolver tanto el razonamiento como la intención.

Prueba el generador de prompts en la Consola Claude para que Claude escriba un primer borrador para ti.

Aquí hay un ejemplo de prompt de clasificación de enrutamiento de tickets:

def classify_support_request(ticket_contents):

# Define the prompt for the classification task

classification_prompt = f"""You will be acting as a customer support ticket classification system. Your task is to analyze customer support requests and output the appropriate classification intent for each request, along with your reasoning.

Here is the customer support request you need to classify:

<request>{ticket_contents}</request>

Please carefully analyze the above request to determine the customer's core intent and needs. Consider what the customer is asking for has concerns about.

First, write out your reasoning and analysis of how to classify this request inside <reasoning> tags.

Then, output the appropriate classification label for the request inside a <intent> tag. The valid intents are:

<intents>

<intent>Support, Feedback, Complaint</intent>

<intent>Order Tracking</intent>

<intent>Refund/Exchange</intent>

</intents>

A request may have ONLY ONE applicable intent. Only include the intent that is most applicable to the request.

As an example, consider the following request:

<request>Hello! I had high-speed fiber internet installed on Saturday and my installer, Kevin, was absolutely fantastic! Where can I send my positive review? Thanks for your help!</request>

Here is an example of how your output should be formatted (for the above example request):

<reasoning>The user seeks information in order to leave positive feedback.</reasoning>

<intent>Support, Feedback, Complaint</intent>

Here are a few more examples:

<examples>

<example 2>

Example 2 Input:

<request>I wanted to write and personally thank you for the compassion you showed towards my family during my father's funeral this past weekend. Your staff was so considerate and helpful throughout this whole process; it really took a load off our shoulders. The visitation brochures were beautiful. We'll never forget the kindness you showed us and we are so appreciative of how smoothly the proceedings went. Thank you, again, Amarantha Hill on behalf of the Hill Family.</request>

Example 2 Output:

<reasoning>User leaves a positive review of their experience.</reasoning>

<intent>Support, Feedback, Complaint</intent>

</example 2>

<example 3>

...

</example 8>

<example 9>

Example 9 Input:

<request>Your website keeps sending ad-popups that block the entire screen. It took me twenty minutes just to finally find the phone number to call and complain. How can I possibly access my account information with all of these popups? Can you access my account for me, since your website is broken? I need to know what the address is on file.</request>

Example 9 Output:

<reasoning>The user requests help accessing their web account information.</reasoning>

<intent>Support, Feedback, Complaint</intent>

</example 9>

Remember to always include your classification reasoning before your actual intent output. The reasoning should be enclosed in <reasoning> tags and the intent in <intent> tags. Return only the reasoning and the intent.

"""Desglosemos los componentes clave de este prompt:

- Usamos f-strings de Python para crear la plantilla de prompt, permitiendo que

ticket_contentsse inserte en las etiquetas<request>. - Le damos a Claude un rol claramente definido como un sistema de clasificación que analiza cuidadosamente el contenido del ticket para determinar la intención central del cliente y las necesidades.

- Instruimos a Claude sobre el formato de salida apropiado, en este caso para proporcionar su razonamiento y análisis dentro de etiquetas

<reasoning>, seguido por la etiqueta de clasificación apropiada dentro de etiquetas<intent>. - Especificamos las categorías de intención válidas: "Support, Feedback, Complaint", "Order Tracking" y "Refund/Exchange".

- Incluimos algunos ejemplos (también conocido como few-shot prompting) para ilustrar cómo debe formatearse la salida, lo que mejora la precisión y la consistencia.

La razón por la que queremos que Claude divida su respuesta en varias secciones de etiquetas XML es para que podamos usar expresiones regulares para extraer por separado el razonamiento y la intención de la salida. Esto nos permite crear pasos siguientes dirigidos en el flujo de trabajo de enrutamiento de tickets, como usar solo la intención para decidir a quién enrutar el ticket.

Implementa tu prompt

Es difícil saber qué tan bien funciona tu prompt sin implementarlo en un entorno de producción de prueba y ejecutar evaluaciones.

Construyamos la estructura de implementación. Comienza definiendo la firma del método para envolver nuestra llamada a Claude. Tomaremos el método que ya hemos comenzado a escribir, que tiene ticket_contents como entrada, y ahora devolveremos una tupla de reasoning e intent como salida. Si tienes una automatización existente usando ML tradicional, querrás seguir esa firma de método en su lugar.

import anthropic

import re

# Create an instance of the Claude API client

client = anthropic.Anthropic()

# Set the default model

DEFAULT_MODEL="claude-haiku-4-5-20251001"

def classify_support_request(ticket_contents):

# Define the prompt for the classification task

classification_prompt = f"""You will be acting as a customer support ticket classification system.

...

... The reasoning should be enclosed in <reasoning> tags and the intent in <intent> tags. Return only the reasoning and the intent.

"""

# Send the prompt to the API to classify the support request.

message = client.messages.create(

model=DEFAULT_MODEL,

max_tokens=500,

temperature=0,

messages=[{"role": "user", "content": classification_prompt}],

stream=False,

)

reasoning_and_intent = message.content[0].text

# Use Python's regular expressions library to extract `reasoning`.

reasoning_match = re.search(

r"<reasoning>(.*?)</reasoning>", reasoning_and_intent, re.DOTALL

)

reasoning = reasoning_match.group(1).strip() if reasoning_match else ""

# Similarly, also extract the `intent`.

intent_match = re.search(r"<intent>(.*?)</intent>", reasoning_and_intent, re.DOTALL)

intent = intent_match.group(1).strip() if intent_match else ""

return reasoning, intentEste código:

- Importa la biblioteca Anthropic y crea una instancia de cliente usando tu clave API.

- Define una función

classify_support_requestque toma una cadenaticket_contents. - Envía

ticket_contentsa Claude para clasificación usandoclassification_prompt - Devuelve el

reasoningeintentdel modelo extraído de la respuesta.

Como necesitamos esperar a que se genere todo el texto de razonamiento e intención antes de analizar, establecemos stream=False (el predeterminado).

Evalúa tu prompt

El prompting a menudo requiere pruebas y optimización para estar listo para producción. Para determinar la preparación de tu solución, evalúa el rendimiento basándote en los criterios de éxito y umbrales que estableciste anteriormente.

Para ejecutar tu evaluación, necesitarás casos de prueba para ejecutarla. El resto de esta guía asume que ya has desarrollado tus casos de prueba.

Construye una función de evaluación

Nuestra evaluación de ejemplo para esta guía mide el rendimiento de Claude a lo largo de tres métricas clave:

- Precisión

- Costo por clasificación

Es posible que necesites evaluar a Claude en otros ejes dependiendo de qué factores sean importantes para ti.

Para evaluar esto, primero tenemos que modificar el script que escribimos y agregar una función para comparar la intención predicha con la intención real y calcular el porcentaje de predicciones correctas. También tenemos que agregar funcionalidad de cálculo de costos y medición de tiempo.

import anthropic

import re

# Create an instance of the Claude API client

client = anthropic.Anthropic()

# Set the default model

DEFAULT_MODEL="claude-haiku-4-5-20251001"

def classify_support_request(request, actual_intent):

# Define the prompt for the classification task

classification_prompt = f"""You will be acting as a customer support ticket classification system.

...

...The reasoning should be enclosed in <reasoning> tags and the intent in <intent> tags. Return only the reasoning and the intent.

"""

message = client.messages.create(

model=DEFAULT_MODEL,

max_tokens=500,

temperature=0,

messages=[{"role": "user", "content": classification_prompt}],

)

usage = message.usage # Get the usage statistics for the API call for how many input and output tokens were used.

reasoning_and_intent = message.content[0].text

# Use Python's regular expressions library to extract `reasoning`.

reasoning_match = re.search(

r"<reasoning>(.*?)</reasoning>", reasoning_and_intent, re.DOTALL

)

reasoning = reasoning_match.group(1).strip() if reasoning_match else ""

# Similarly, also extract the `intent`.

intent_match = re.search(r"<intent>(.*?)</intent>", reasoning_and_intent, re.DOTALL)

intent = intent_match.group(1).strip() if intent_match else ""

# Check if the model's prediction is correct.

correct = actual_intent.strip() == intent.strip()

# Return the reasoning, intent, correct, and usage.

return reasoning, intent, correct, usageDesglosemos las ediciones que hemos hecho:

- Agregamos

actual_intentde nuestros casos de prueba al métodoclassify_support_requesty configuramos una comparación para evaluar si la clasificación de intención de Claude coincide con nuestra clasificación de intención dorada. - Extrajimos estadísticas de uso para la llamada API para calcular el costo basado en tokens de entrada y salida utilizados

Ejecuta tu evaluación

Una evaluación adecuada requiere umbrales y puntos de referencia claros para determinar qué es un buen resultado. El script anterior nos dará los valores de tiempo de ejecución para precisión, tiempo de respuesta y costo por clasificación, pero aún necesitaríamos umbrales claramente establecidos. Por ejemplo:

- Precisión: 95% (de 100 pruebas)

- Costo por clasificación: Reducción del 50% en promedio (en 100 pruebas) del método de enrutamiento actual

Tener estos umbrales te permite decir rápida y fácilmente a escala, y con empirismo imparcial, qué método es mejor para ti y qué cambios podrían necesitarse para adaptarse mejor a tus requisitos.

Mejora el rendimiento

En escenarios complejos, puede ser útil considerar estrategias adicionales para mejorar el rendimiento más allá de las técnicas estándar de ingeniería de prompts y estrategias de implementación de guardrails. Aquí hay algunos escenarios comunes:

Usa una jerarquía taxonómica para casos con 20+ categorías de intención

A medida que crece el número de clases, el número de ejemplos requeridos también se expande, potencialmente haciendo que el prompt sea difícil de manejar. Como alternativa, puedes considerar implementar un sistema de clasificación jerárquico usando una mezcla de clasificadores.

- Organiza tus intenciones en una estructura de árbol taxonómico.

- Crea una serie de clasificadores en cada nivel del árbol, habilitando un enfoque de enrutamiento en cascada.

Por ejemplo, podrías tener un clasificador de nivel superior que categoriza ampliamente los tickets en "Problemas Técnicos", "Preguntas de Facturación" e "Consultas Generales". Cada una de estas categorías puede tener su propio subclasificador para refinar aún más la clasificación.

-

Pros - mayor matiz y precisión: Puedes crear diferentes prompts para cada ruta padre, permitiendo una clasificación más dirigida y específica del contexto. Esto puede conducir a una precisión mejorada y un manejo más matizado de las solicitudes de los clientes.

-

Contras - latencia aumentada: Ten en cuenta que múltiples clasificadores pueden conducir a una latencia aumentada, y recomendamos implementar este enfoque con nuestro modelo más rápido, Haiku.

Usa bases de datos vectoriales y búsqueda de similitud de recuperación para manejar tickets altamente variables

A pesar de que proporcionar ejemplos es la forma más efectiva de mejorar el rendimiento, si las solicitudes de soporte son altamente variables, puede ser difícil incluir suficientes ejemplos en un solo prompt.

En este escenario, podrías emplear una base de datos vectorial para hacer búsquedas de similitud desde un conjunto de datos de ejemplos y recuperar los ejemplos más relevantes para una consulta dada.

Este enfoque, descrito en detalle en nuestra receta de clasificación, ha demostrado mejorar el rendimiento del 71% de precisión al 93% de precisión.

Cuenta específicamente para casos extremos esperados

Aquí hay algunos escenarios donde Claude puede clasificar incorrectamente tickets (puede haber otros que sean únicos para tu situación). En estos escenarios, considera proporcionar instrucciones explícitas o ejemplos en el prompt de cómo Claude debe manejar el caso extremo:

Integra Claude en tu flujo de trabajo de soporte más amplio

La integración adecuada requiere que tomes algunas decisiones sobre cómo tu script de enrutamiento de tickets basado en Claude se ajusta a la arquitectura de tu sistema de enrutamiento de tickets más amplio. Hay dos formas en que podrías hacer esto:

- Basado en push: El sistema de tickets de soporte que estés usando (p. ej. Zendesk) activa tu código enviando un evento webhook a tu servicio de enrutamiento, que luego clasifica la intención y la enruta.

- Este enfoque es más escalable en la web, pero necesita que expongas un punto final público.

- Basado en pull: Tu código extrae los últimos tickets basándose en un cronograma dado y los enruta en el momento del pull.

- Este enfoque es más fácil de implementar pero podría hacer llamadas innecesarias al sistema de tickets de soporte cuando la frecuencia de pull es demasiado alta o podría ser demasiado lento cuando la frecuencia de pull es demasiado baja.

Para cualquiera de estos enfoques, necesitarás envolver tu script en un servicio. La elección del enfoque depende de qué APIs proporcione tu sistema de tickets de soporte.