Aqui estão alguns indicadores-chave de que você deve usar um LLM como Claude em vez de abordagens tradicionais de ML para sua tarefa de classificação:

Was this page helpful?

Antes de mergulhar na automação, é crucial entender seu sistema de ticketing existente. Comece investigando como sua equipe de suporte atualmente lida com o roteamento de tickets.

Considere perguntas como:

Quanto mais você souber sobre como os humanos lidam com certos casos, melhor você será capaz de trabalhar com Claude para fazer a tarefa.

Uma lista bem definida de categorias de intenção do usuário é crucial para classificação precisa de tickets de suporte com Claude. A capacidade do Claude de rotear tickets efetivamente dentro de seu sistema é diretamente proporcional ao quão bem definidas são as categorias do seu sistema.

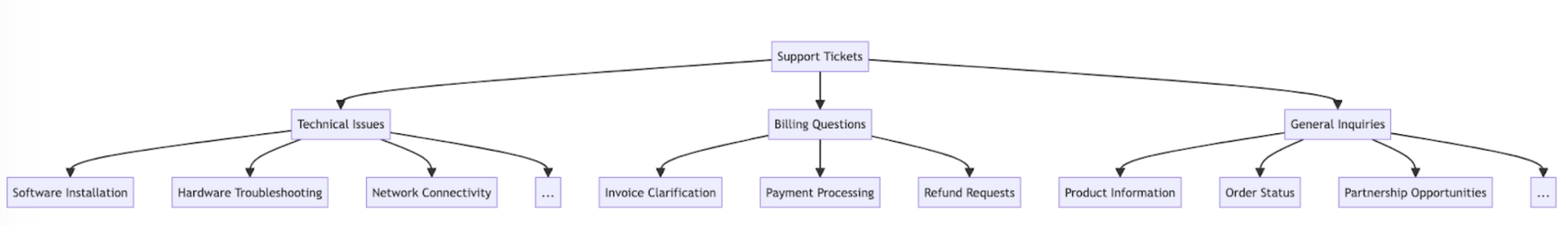

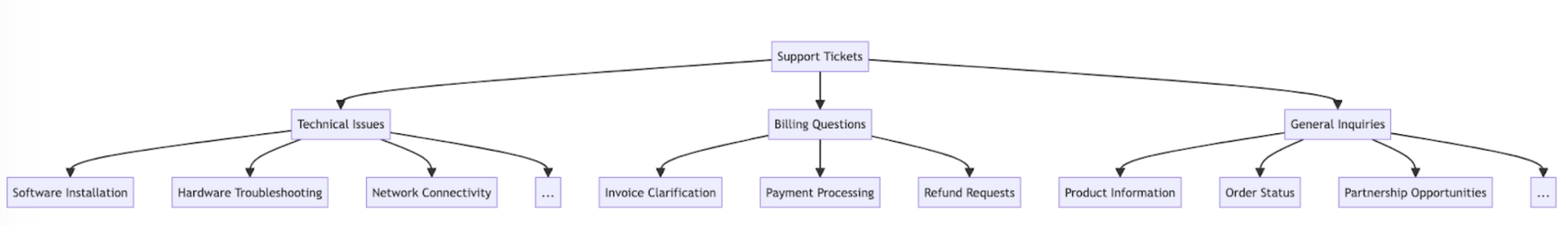

Aqui estão algumas categorias e subcategorias de intenção do usuário de exemplo.

Além da intenção, o roteamento e priorização de tickets também podem ser influenciados por outros fatores, como urgência, tipo de cliente, SLAs ou idioma. Certifique-se de considerar outros critérios de roteamento ao construir seu sistema de roteamento automatizado.

Trabalhe com sua equipe de suporte para definir critérios de sucesso claros com benchmarks, limites e objetivos mensuráveis.

Aqui estão alguns critérios e benchmarks padrão ao usar LLMs para roteamento de tickets de suporte:

Aqui estão alguns critérios de sucesso comuns que podem ser úteis independentemente de um LLM ser usado:

A escolha do modelo depende dos trade-offs entre custo, precisão e tempo de resposta.

Muitos clientes descobriram que claude-haiku-4-5-20251001 é um modelo ideal para roteamento de tickets, pois é o modelo mais rápido e mais econômico da família Claude 4, enquanto ainda oferece excelentes resultados. Se seu problema de classificação requer profunda experiência em assuntos ou um grande volume de categorias de intenção com raciocínio complexo, você pode optar pelo modelo Sonnet maior.

O roteamento de tickets é um tipo de tarefa de classificação. Claude analisa o conteúdo de um ticket de suporte e o classifica em categorias predefinidas com base no tipo de problema, urgência, experiência necessária ou outros fatores relevantes.

Vamos escrever um prompt de classificação de tickets. Nosso prompt inicial deve conter o conteúdo da solicitação do usuário e retornar tanto o raciocínio quanto a intenção.

Tente o gerador de prompt no Console Claude para que Claude escreva um primeiro rascunho para você.

Aqui está um exemplo de prompt de classificação de roteamento de tickets:

def classify_support_request(ticket_contents):

# Define the prompt for the classification task

classification_prompt = f"""You will be acting as a customer support ticket classification system. Your task is to analyze customer support requests and output the appropriate classification intent for each request, along with your reasoning.

Here is the customer support request you need to classify:

<request>{ticket_contents}</request>

Please carefully analyze the above request to determine the customer's core intent and needs. Consider what the customer is asking for has concerns about.

First, write out your reasoning and analysis of how to classify this request inside <reasoning> tags.

Then, output the appropriate classification label for the request inside a <intent> tag. The valid intents are:

<intents>

<intent>Support, Feedback, Complaint</intent>

<intent>Order Tracking</intent>

<intent>Refund/Exchange</intent>

</intents>

A request may have ONLY ONE applicable intent. Only include the intent that is most applicable to the request.

As an example, consider the following request:

<request>Hello! I had high-speed fiber internet installed on Saturday and my installer, Kevin, was absolutely fantastic! Where can I send my positive review? Thanks for your help!</request>

Here is an example of how your output should be formatted (for the above example request):

<reasoning>The user seeks information in order to leave positive feedback.</reasoning>

<intent>Support, Feedback, Complaint</intent>

Here are a few more examples:

<examples>

<example 2>

Example 2 Input:

<request>I wanted to write and personally thank you for the compassion you showed towards my family during my father's funeral this past weekend. Your staff was so considerate and helpful throughout this whole process; it really took a load off our shoulders. The visitation brochures were beautiful. We'll never forget the kindness you showed us and we are so appreciative of how smoothly the proceedings went. Thank you, again, Amarantha Hill on behalf of the Hill Family.</request>

Example 2 Output:

<reasoning>User leaves a positive review of their experience.</reasoning>

<intent>Support, Feedback, Complaint</intent>

</example 2>

<example 3>

...

</example 8>

<example 9>

Example 9 Input:

<request>Your website keeps sending ad-popups that block the entire screen. It took me twenty minutes just to finally find the phone number to call and complain. How can I possibly access my account information with all of these popups? Can you access my account for me, since your website is broken? I need to know what the address is on file.</request>

Example 9 Output:

<reasoning>The user requests help accessing their web account information.</reasoning>

<intent>Support, Feedback, Complaint</intent>

</example 9>

Remember to always include your classification reasoning before your actual intent output. The reasoning should be enclosed in <reasoning> tags and the intent in <intent> tags. Return only the reasoning and the intent.

"""Vamos decompor os componentes-chave deste prompt:

ticket_contents seja inserido nas tags <request>.<reasoning>, seguidas pelo rótulo de classificação apropriado dentro de tags <intent>.A razão pela qual queremos que Claude divida sua resposta em várias seções de tags XML é para que possamos usar expressões regulares para extrair separadamente o raciocínio e a intenção da saída. Isso nos permite criar próximos passos direcionados no fluxo de trabalho de roteamento de tickets, como usar apenas a intenção para decidir para qual pessoa rotear o ticket.

É difícil saber o quão bem seu prompt funciona sem implantá-lo em um ambiente de produção de teste e executar avaliações.

Vamos construir a estrutura de implantação. Comece definindo a assinatura do método para envolver nossa chamada ao Claude. Vamos pegar o método que já começamos a escrever, que tem ticket_contents como entrada, e agora retornar uma tupla de reasoning e intent como saída. Se você tiver uma automação existente usando ML tradicional, você vai querer seguir essa assinatura de método.

import anthropic

import re

# Create an instance of the Claude API client

client = anthropic.Anthropic()

# Set the default model

DEFAULT_MODEL="claude-haiku-4-5-20251001"

def classify_support_request(ticket_contents):

# Define the prompt for the classification task

classification_prompt = f"""You will be acting as a customer support ticket classification system.

...

... The reasoning should be enclosed in <reasoning> tags and the intent in <intent> tags. Return only the reasoning and the intent.

"""

# Send the prompt to the API to classify the support request.

message = client.messages.create(

model=DEFAULT_MODEL,

max_tokens=500,

temperature=0,

messages=[{"role": "user", "content": classification_prompt}],

stream=False,

)

reasoning_and_intent = message.content[0].text

# Use Python's regular expressions library to extract `reasoning`.

reasoning_match = re.search(

r"<reasoning>(.*?)</reasoning>", reasoning_and_intent, re.DOTALL

)

reasoning = reasoning_match.group(1).strip() if reasoning_match else ""

# Similarly, also extract the `intent`.

intent_match = re.search(r"<intent>(.*?)</intent>", reasoning_and_intent, re.DOTALL)

intent = intent_match.group(1).strip() if intent_match else ""

return reasoning, intentEste código:

classify_support_request que recebe uma string ticket_contents.ticket_contents ao Claude para classificação usando o classification_promptreasoning e intent do modelo extraído da resposta.Como precisamos esperar que todo o texto de raciocínio e intenção seja gerado antes de analisar, definimos stream=False (o padrão).

O prompting frequentemente requer testes e otimização para estar pronto para produção. Para determinar a prontidão de sua solução, avalie o desempenho com base nos critérios de sucesso e limites que você estabeleceu anteriormente.

Para executar sua avaliação, você precisará de casos de teste para executá-la. O resto deste guia assume que você já desenvolveu seus casos de teste.

Nossa avaliação de exemplo para este guia mede o desempenho do Claude ao longo de três métricas-chave:

Você pode precisar avaliar Claude em outros eixos dependendo de quais fatores são importantes para você.

Para avaliar isso, primeiro temos que modificar o script que escrevemos e adicionar uma função para comparar a intenção prevista com a intenção real e calcular a porcentagem de previsões corretas. Também temos que adicionar funcionalidade de cálculo de custo e medição de tempo.

import anthropic

import re

# Create an instance of the Claude API client

client = anthropic.Anthropic()

# Set the default model

DEFAULT_MODEL="claude-haiku-4-5-20251001"

def classify_support_request(request, actual_intent):

# Define the prompt for the classification task

classification_prompt = f"""You will be acting as a customer support ticket classification system.

...

...The reasoning should be enclosed in <reasoning> tags and the intent in <intent> tags. Return only the reasoning and the intent.

"""

message = client.messages.create(

model=DEFAULT_MODEL,

max_tokens=500,

temperature=0,

messages=[{"role": "user", "content": classification_prompt}],

)

usage = message.usage # Get the usage statistics for the API call for how many input and output tokens were used.

reasoning_and_intent = message.content[0].text

# Use Python's regular expressions library to extract `reasoning`.

reasoning_match = re.search(

r"<reasoning>(.*?)</reasoning>", reasoning_and_intent, re.DOTALL

)

reasoning = reasoning_match.group(1).strip() if reasoning_match else ""

# Similarly, also extract the `intent`.

intent_match = re.search(r"<intent>(.*?)</intent>", reasoning_and_intent, re.DOTALL)

intent = intent_match.group(1).strip() if intent_match else ""

# Check if the model's prediction is correct.

correct = actual_intent.strip() == intent.strip()

# Return the reasoning, intent, correct, and usage.

return reasoning, intent, correct, usageVamos decompor as edições que fizemos:

actual_intent de nossos casos de teste ao método classify_support_request e configuramos uma comparação para avaliar se a classificação de intenção do Claude corresponde à nossa classificação de intenção dourada.Uma avaliação adequada requer limites e benchmarks claros para determinar o que é um bom resultado. O script acima nos dará os valores de tempo de execução para precisão, tempo de resposta e custo por classificação, mas ainda precisaríamos de limites claramente estabelecidos. Por exemplo:

Ter esses limites permite que você diga rápida e facilmente em escala, e com empirismo imparcial, qual método é melhor para você e quais mudanças podem precisar ser feitas para se adequar melhor aos seus requisitos.

Em cenários complexos, pode ser útil considerar estratégias adicionais para melhorar o desempenho além das técnicas padrão de engenharia de prompt e estratégias de implementação de guardrails. Aqui estão alguns cenários comuns:

À medida que o número de classes cresce, o número de exemplos necessários também se expande, potencialmente tornando o prompt difícil de usar. Como alternativa, você pode considerar implementar um sistema de classificação hierárquica usando uma mistura de classificadores.

Por exemplo, você pode ter um classificador de nível superior que categoriza amplamente os tickets em "Problemas Técnicos", "Perguntas de Faturamento" e "Consultas Gerais". Cada uma dessas categorias pode então ter seu próprio sub-classificador para refinar ainda mais a classificação.

Prós - maior nuance e precisão: Você pode criar prompts diferentes para cada caminho pai, permitindo classificação mais direcionada e específica do contexto. Isso pode levar a maior precisão e manipulação mais nuançada de solicitações de clientes.

Contras - latência aumentada: Esteja ciente de que vários classificadores podem levar a latência aumentada, e recomendamos implementar essa abordagem com nosso modelo mais rápido, Haiku.

Apesar de fornecer exemplos ser a forma mais eficaz de melhorar o desempenho, se as solicitações de suporte forem altamente variáveis, pode ser difícil incluir exemplos suficientes em um único prompt.

Neste cenário, você pode empregar um banco de dados vetorial para fazer buscas de similaridade a partir de um conjunto de dados de exemplos e recuperar os exemplos mais relevantes para uma determinada consulta.

Esta abordagem, descrita em detalhes em nossa receita de classificação, foi mostrada para melhorar o desempenho de 71% de precisão para 93% de precisão.

Aqui estão alguns cenários onde Claude pode classificar incorretamente tickets (pode haver outros que são únicos para sua situação). Nestes cenários, considere fornecer instruções explícitas ou exemplos no prompt de como Claude deve lidar com o caso extremo:

A integração adequada requer que você tome algumas decisões sobre como seu script de roteamento de tickets baseado em Claude se encaixa na arquitetura de seu sistema de roteamento de tickets maior. Existem duas maneiras pelas quais você pode fazer isso:

Para qualquer uma dessas abordagens, você precisará envolver seu script em um serviço. A escolha da abordagem depende de quais APIs seu sistema de ticketing de suporte fornece.